NL-069, Language Models are Few-Shot Learners (GPT3) (2020.05-Arxiv)

■ Comment

- 이 논문은 상당히 길다.. ref를 빼도 65페이지라 다 열심히 읽는 데는 너무 오래걸린다..

- 간단히 몇 가지 핵심 부분만 읽고, 정리하는 시간을 최소화하기 위해 번역기를 이용했다.

- 이상하거나 의미전달이 안되는 부분만 조금 수정하는 정도?

- 정리하지 않은 부분은 reference에 유튜브에 논문 정리하신 부분을 들으면 될 것 같다.

- 전체적으로 fine-tuned 없이 few-shot만으로도 충분히 좋은 성능을 보여주는게 가장 큰 contribution이다.

- 이러한 학습방법을 prompt engineering이라 부르는 것 같다.

- fine-tuning없이 zero-shot, one-shot, few-shot을 한다는 것의 의미는 이런 것이다.

- "영어를 한국어로 번역하세요", "I am happy --> 나는 기쁘다"와 같이 예제를 보여준다.

- 즉 위의 task 설명과 예제과 초기 context으로 들어가고 "I am blue -->"가 뒷 context으로 들어가면 생성으로 "나는 우울하다"가 생성되도록 하는 식이다.

- 모델의 스타일?은 GPT2와 모델이 똑같으며, 파라미터의 수를 엄청 늘리기도, 줄이기도 하면서 실험을 한 것이다.

- 당연히 파라미터 수가 증가할 수록 모델의 성능이 좋아진다

- 엄청나게 많은 실험을 하면서, 모델의 성능을 입증했으며, 숫자의 사칙연산, 영어 문법 고치기 등 색다른 실험들도 하였다.

- huggingface쪽에서 사용할 수 있도록 제공하기를 희망한다..

- limitations에 GPT3의 약점들에 적어둔 거 있으니 이 부분은 읽어보면 좋을 것이다.

0. Abstract

- 최근의 연구는 대규모 텍스트에 대한 사전 교육을 실시한 후 특정 작업에 대한 세부 조정을 통해 많은 NLP 과제와 벤치마크에서 상당한 이득을 얻고 있다.

- 일반적으로 아키텍처에서는 작업에 제한이 없지만, 이 방법은 여전히 수천 또는 수만 개의 예제로 구성된 작업별 세부 조정 데이터셋을 필요로 한다.

- 이와는 대조적으로, 인간은 일반적으로 단지 몇 가지 예나 간단한 지시로부터 새로운 언어 과제를 수행할 수 있는데, 이것은 현재의 NLP 시스템들이 아직도 대부분 하기 힘든 일이다.

- Here we show that scaling up language models greatly improves task-agnostic, few-shot performance, sometimes even reaching competitiveness with prior state-of-the-art finetuning approaches.

- 구체적으로, 우리는 이전의 어떤 non-sparse language model보다 10배 많은 1,750억 개의 매개변수를 가진 autoregressive 언어 모델인 GPT-3를 훈련하고, 그 성능을 몇 발의 설정에서 시험한다.

- 모든 작업에 대해 GPT-3는 Gradient 업데이트나 미세 조정 없이 적용되며, 모델과의 문자 상호작용을 통해 순전히 지정된 작업과 소사격 데모가 있다.

- GPT-3는 번역, 문제해결, 클로즈 작업 등 많은 NLP 데이터셋에서 강력한 성능을 발휘하며, 문장의 참신한 단어를 사용하거나 3자리 산수를 수행하는 등 즉석 추론이나 도메인 적응이 필요한 여러 작업에서도 높은 성능을 발휘한다.

- 동시에, 우리는 GPT-3의 몇 안 되는 학습이 여전히 어려움을 겪고 있는 일부 데이터셋과 GPT-3가 대규모 웹 기업에서의 훈련과 관련된 방법론적 문제에 직면하고 있는 데이터셋도 식별한다.

- 마지막으로, GPT-3는 인간 평가자가 인간이 작성한 기사와 구별하기 어려운 뉴스 기사의 샘플을 생성할 수 있다는 것을 알게 된다.

- 우리는 이 발견과 GPT-3의 전반적인 사회적 영향에 대해 논의한다.

1. Introduction

- 최근 몇 년 동안 NLP 시스템에서 사전 교육된 언어 표현에 대한 추세를 보여주었는데, 이는 다운스트림 전송에 대해 점점 더 유연하고 작업 task-agnostic 방식으로 적용되었다.

- 첫째, 단층 표현은 단어 벡터를 사용하여 학습되었고 작업별 아키텍처에 공급되었다. 그 다음, 여러 계층의 표현과 상황별 상태를 가진 RNN을 사용하여 더 강력한 표현을 형성하였다(작업별 아키텍처에 여전히 적용됨), 그리고 더 최근에 사전 훈련된 RNN 또는 Transformer 언어 모델은 작업별 아키텍처의 필요성을 완전히 제거하면서 직접적으로 미세 조정되었다.

- 이 마지막 패러다임은 읽기 이해, 문제 답변, 텍스트 참여 등과 같은 많은 도전적인 NLP 과제에서 상당한 진전을 이루었으며, 새로운 아키텍처와 알고리즘에 기초하여 지속적으로 발전해 왔다.

- 그러나, 이 접근방식의 주요 제한사항은 아키텍처가 작업에 영향을 미치지 않지만, 작업별 데이터셋과 작업별 세부 조정이 여전히 필요하다는 것이다.

- 즉, 원하는 작업에서 강력한 성능을 달성하려면 일반적으로 해당 작업에 특정된 수천에서 수십만 개의 데이터셋을 세부적으로 조정해야 한다.

- 몇 가지 이유로 이러한 제한을 없애는 것이 바람직할 것이다.

- 1) 첫째, 실제적인 관점에서, 모든 새로운 작업에 대해 라벨로 표시된 예제의 대규모 데이터 집합의 필요성은 언어 모델의 적용 가능성을 제한한다.

- 문법 교정에서부터 추상적인 개념의 예시 생성, 단편 소설 비평에 이르기까지 가능한 유용한 언어 과제의 범위가 매우 넓다.

- For many of these tasks it is difficult to collect a large supervised training dataset, especially when the process must be repeated for every new task.

- 2) 둘째, 모델의 표현력과 훈련 분포의 협소함에 따라 훈련 데이터의 거짓 상관관계를 이용할 가능성이 근본적으로 증가한다.

- 이는 사전 훈련 플러스 미세 조정 패러다임에 문제를 일으킬 수 있는데, 사전 훈련 중에는 모델이 정보를 흡수하도록 크도록 설계되었지만, 이후 매우 좁은 작업 분배에 따라 미세 조정된다.

- 예를 들어 [HLW+20]의 경우 대형 모델이 반드시 분배 이탈을 더 잘 일반화하는 것은 아니라는 점에 유의하십시오.

- 이 패러다임 하에서 달성한 일반화가 저조할 수 있다는 증거가 있는데, 이는 모델이 훈련 분포에 지나치게 구체화되어 있고 그 외부에서 잘 일반화되지 않기 때문이다 [YdC+19, MPL19].

- 따라서 특정 벤치마크에서 미세 조정된 모델의 성능은 명목상 인간 수준에 있는 경우에도 기본 과제에 대한 실제 성능을 과장할 수 있다[GSL+18, NK19].

- 3) 셋째, 인간은 대부분의 언어 작업을 배우기 위해 감독되는 대규모 데이터셋을 요구하지 않는다

- 자연어로 간략한 지시(예: “please tell me if this sentence describes something happy or something sad”)

- 또는 적은 수의 데모(예:“here are two examples of people acting brave; please give a third example of bravery”)는 인간이 적어도 합리적인 수준의 능력으로 새로운 임무를 수행할 수 있게 하기에 충분하다.

- 현재 NLP 기법의 개념적 한계를 지적하는 것 외에도, 이러한 적응성은 실제적인 이점을 가지고 있다 – 예를 들어 긴 대화 중에 추가 작업을 수행하는 등 인간이 서로 원활하게 섞이거나 여러 작업과 기술 사이를 전환할 수 있게 해준다.

- 광범위하게 유용하게 쓰이기 위해, 우리는 언젠가 우리의 NLP 시스템이 이와 같은 유동성(fluidity)과 일반성(generality)을 갖기를 바란다.

- 이러한 문제를 해결하기 위한 한 가지 잠재적인 경로는 메타 학습이다.

- 즉, 언어 모델의 맥락에서 모델은 훈련 시간에 광범위한 기술과 패턴 인식 능력을 개발하며, 그런 능력을 추론 시간에 사용하여 원하는 작업에 신속하게 적응하거나 인식한다(그림 1.1 참조).

- 최근 작업 [RWC+19]에서는 사전 검증된 언어 모델의 텍스트 입력을 과제 명세서의 한 형태로 사용하여 이른바 "컨텍스트 내 학습"을 통해 이를 시도한다.

- 모델은 자연어 지침 및/또는 몇 가지 작업 시연에 따라 조건화되며, 그 다음에 무엇이 올지 예측하는 것만으로 작업의 추가 인스턴스를 완성할 것으로 예상된다.

- 그것이 약간의 초기 약속을 보여주었지만, 이 접근방식은 여전히 미세 조정보다 훨씬 낮은 결과를 얻는다.

- 예를 들어 [RWC+19]는 자연 문제에서 4%만 달성하고 55 F1 CoQa 결과조차도 현재 기술 상태에 35점 이상 뒤처져 있다.

- 메타 학습은 언어 과제의 실질적인 해결 방법으로 실현되기 위해서는 상당한 개선이 분명히 필요하다.

- 언어 모델링의 또 다른 최근의 경향은 앞으로 나아갈 길을 제시할 수도 있다.

- 근년에 Transformer 언어 모델의 용량은 1억 매개변수[RNSS18]에서 3억 매개변수[DCLT18]로, 15억 매개변수[RWC+19]로, 80억 매개변수[SPP+19]로, 110억 매개변수[RSR+19]로, 마지막으로 170억 매개변수[Tur20]로 크게 증가했다.

- 각 증가는 텍스트 합성 및/또는 다운스트림 NLP 작업의 개선을 가져왔고, 많은 다운스트림 작업과 잘 상관되는 로그 손실이 규모[KMH+20]로 부드러운 개선 추세를 따른다는 증거가 있다.

- in-context learning은 모델의 매개변수 내에서 많은 기술과 과제를 흡수하는 것을 포함하므로, in-context learning 능력은 규모에 따라 유사하게 강한 이득을 보일 수 있다.

- 본 논문에서는 GPT-3라고 하는 1,750억 개의 매개변수 자기 회귀 언어 모델을 훈련시키고, 그 교내 학습 능력을 측정함으로써 이 가설을 시험한다.

- 구체적으로, 우리는 교육 세트에 직접적으로 포함될 것 같지 않은 과제에 대한 신속한 적응을 시험하기 위해 고안된 몇 가지 새로운 과제뿐만 아니라, 24개 이상의 NLP 데이터셋에 대해 GPT-3를 평가한다.

- 각 과제에 대해 GPT-3를 다음의 3가지 조건에서 평가한다.

- (a) “few-shot learning”, or in-context learning where we allow as many demonstrations as will fit into the model’s context window (typically 10 to 100),

- (b) “one-shot learning”, where we allow only one demonstration, and

- (c) “zero-shot” learning, where no demonstrations are allowed

- and only an instruction in natural language is given to the model.

- GPT-3는 또한 원칙적으로 전통적인 미세 조정 환경에서 평가될 수 있지만, 우리는 이것을 향후 작업에 맡긴다.

- 그림 1.2는 우리가 공부하는 조건을 보여주고, 모델이 단어에서 관련 없는 기호를 제거해야 하는 간단한 과제에 대한 몇 발의 학습을 보여준다.

- 모델 성능은 자연어 작업 설명이 추가되고 모델 컨텍스트의 예시 수 K가 추가되면서 향상된다.

- 모델 사이즈에 따라 소량 학습도 획기적으로 향상된다. 이 사례의 결과는 특히 두드러지지만, 모델 크기와 컨텍스트 내 예제 수를 모두 가진 일반적인 추세는 우리가 연구하는 대부분의 과제에서 유효하다.

- 우리는 이러한 "학습" 곡선은 구배 업데이트나 미세 조정 없이 단지 조건화로서 주어진 데모의 수를 증가시킨다는 것을 강조한다.

- 대체로, NLP 작업에서 GPT-3는 제로샷과 원샷 설정에서 유망한 결과를 달성하며, 몇 개의 샷 설정에서 때로는 첨단 모델과 경쟁적이거나 심지어 때로는 능가하기도 한다(정밀 튜닝된 모델에 의해 최신 모델을 보유함에도 불구하고).

- 예를 들어 GPT-3는 제로샷 설정에서 CoQA 81.5 F1을 달성하고, CoQA 84.0 F1은 원샷 설정에서, 85.0 F1은 몇 샷 설정에서 달성한다.

- 마찬가지로, GPT-3는 제로샷 설정에서 TriviaQA 64.3%, 원샷 설정에서 68.0%, 수샷 설정에서 71.2%의 정확도를 달성하는데, 그 중 마지막은 동일한 비공개 설정에서 작동하는 미세 조정된 모델에 비해 최첨단이다.

- GPT-3는 또한 단 한 번만 정의되는 단어를 보고 문장에서 새로운 단어를 사용하는 것을 포함하는 신속한 적응이나 즉석 추론을 시험하기 위해 고안된 과제에 원샷과 적은 샷의 숙련도를 보여준다.

- 우리는 또한 몇 번의 촬영 환경에서 GPT-3는 인간 평가자들이 인간이 만든 기사들과 구별하기 어려운 합성 뉴스 기사를 생성할 수 있다는 것을 보여준다.

- 동시에, 우리는 GPT-3의 규모에서도, 거의 촬영되지 않은 성능의 고전을 면치 못하는 몇몇 과제들을 발견한다.

- 여기에는 ANLI 데이터 집합과 같은 자연 언어 추론 작업과 RACE 또는 QuAC와 같은 일부 읽기 이해 데이터 집합이 포함된다.

- 이러한 한계를 포함한 GPT-3의 장단점에 대한 폭넓은 특성화를 제시함으로써, 언어 모델에서 몇 발의 단점 학습에 대한 연구를 자극해 진보가 가장 필요한 곳에 관심을 끌 수 있기를 기대한다.

- 전체 결과에 대한 경험적 접근의식은 다양한 작업을 집대성한 그림 1.3에서 볼 수 있다(그 자체로 엄격하거나 의미 있는 벤치마크로 보여서는 안 된다).

- 당사는 또한 "data contamination(데이터 오염)"에 대한 체계적인 연구를 수행하는데, 이는 단순히 테스트 데이터셋의 콘텐츠가 웹 상에 존재한다는 이유만으로 잠재적으로 포함될 수 있는 공통 크롤과 같은 데이터셋에서 대용량 모델을 교육할 때 발생하는 문제인 것이다.

- 이 논문에서는 데이터 오염을 측정하고 왜곡된 영향을 수량화하기 위한 체계적인 도구를 개발한다. 데이터 오염이 대부분의 데이터셋에서 GPT-3의 성능에 최소한의 영향을 미친다는 것을 발견했지만, 우리는 결과를 부풀릴 수 있는 데이터셋을 몇 개 식별하고, 심각도에 따라 이러한 데이터셋에 대한 결과를 보고하거나 별표를 붙이지 않는다.

- 위의 모든 것 외에도, zero, one and few-shot settings에서 GPT-3와 성능을 비교하기 위해 일련의 소형 모델(매개변수 1억 2,500만개에서 130억개까지의 범위)을 훈련한다.

- 일반적으로 대부분의 작업에 대해 우리는 세 가지 설정 모두에서 모델 용량으로 비교적 원활한 확장성을 발견한다.

- 한 가지 주목할 만한 패턴은 모델 용량에 따라 제로, 원샷 및 소샷 성능 간의 차이가 종종 증가한다는 것이며, 이는 아마도 대형 모델이 더 숙련된 메타 학습자임을 시사하는 것일 것이다.

- 마지막으로, GPT-3가 보여주는 광범위한 기능 스펙트럼을 고려할 때, 편향, 공정성 및 광범위한 사회적 영향에 대한 우려를 논의하고, 이와 관련된 GPT-3의 특성에 대한 예비 분석을 시도한다.

2 Approach

- 모델, 데이터 및 훈련을 포함한 기본적인 사전 교육 접근방식은 [RWC+19]에 설명된 프로세스와 유사하며, 모델 크기, 데이터 집합 크기 및 다양성, 교육 기간 등을 비교적 쉽게 확장한다.

- 컨텍스트 내 학습의 사용도 [RWC+19]와 유사하지만, 본 연구에서는 문맥 내에서 학습을 위한 다양한 설정을 체계적으로 탐구한다.

- 따라서 우리는 GPT-3를 평가하거나 원칙적으로 GPT-3를 평가할 수 있는 여러 설정을 명시적으로 정의하고 대조함으로써 이 절을 시작한다.

- 이러한 설정은 작업별 데이터에 의존하는 경향이 있는 스펙트럼에 놓여 있는 것으로 볼 수 있다. 구체적으로는 이 스펙트럼에서 최소 4개의 지점을 식별할 수 있다(그림 2.1 참조).

- Fine-Tuning (FT)

- FT(Fine-Tuning)는 최근 몇 년 동안 가장 일반적인 접근 방식이었으며, 원하는 작업에 특정한 감독된 데이터 집합에 대한 교육을 통해 사전 훈련된 모델의 가중치를 업데이트하는 것을 포함한다.

- 일반적으로 수천에서 수십만 개의 라벨이 부착된 예가 사용된다. 미세 조정의 가장 큰 장점은 많은 벤치마크에서 강한 성능을 보인다는 것이다.

- The main disadvantages are the need for a new large dataset for every task, the potential for poor generalization out-of-distribution [MPL19], and the potential to exploit spurious(가짜) features of the training data [GSL+18, NK19], potentially resulting in an unfair comparison with human performance.

- 본 작업에서는 task-agnostic에 초점을 맞추고 있기 때문에 GPT-3를 미세 조정하지 않지만, GPT-3는 원칙적으로 미세 조정될 수 있으며, 이것이 향후 작업에 대한 유망한 방향이다.

- Few-Shot (FS)

- Few-Shot는 추론 시간에 모델의 작업 데모가 조건화[RWC+19]로 주어지는 설정을 참조하기 위해 본 연구에서 사용할 용어지만 중량 업데이트는 허용되지 않는다.

- 여기서는 task-specific에 해당하는 few samples을 따로 모아서 웨이트를 업데이트 시키는 개념이라기 보단, prompt engineering으로 활용되는 것

- 이 효과로 인해 몇 개의 samples을 본 것만으로 성능이 좋아진다는 것을 말하고 싶은 듯

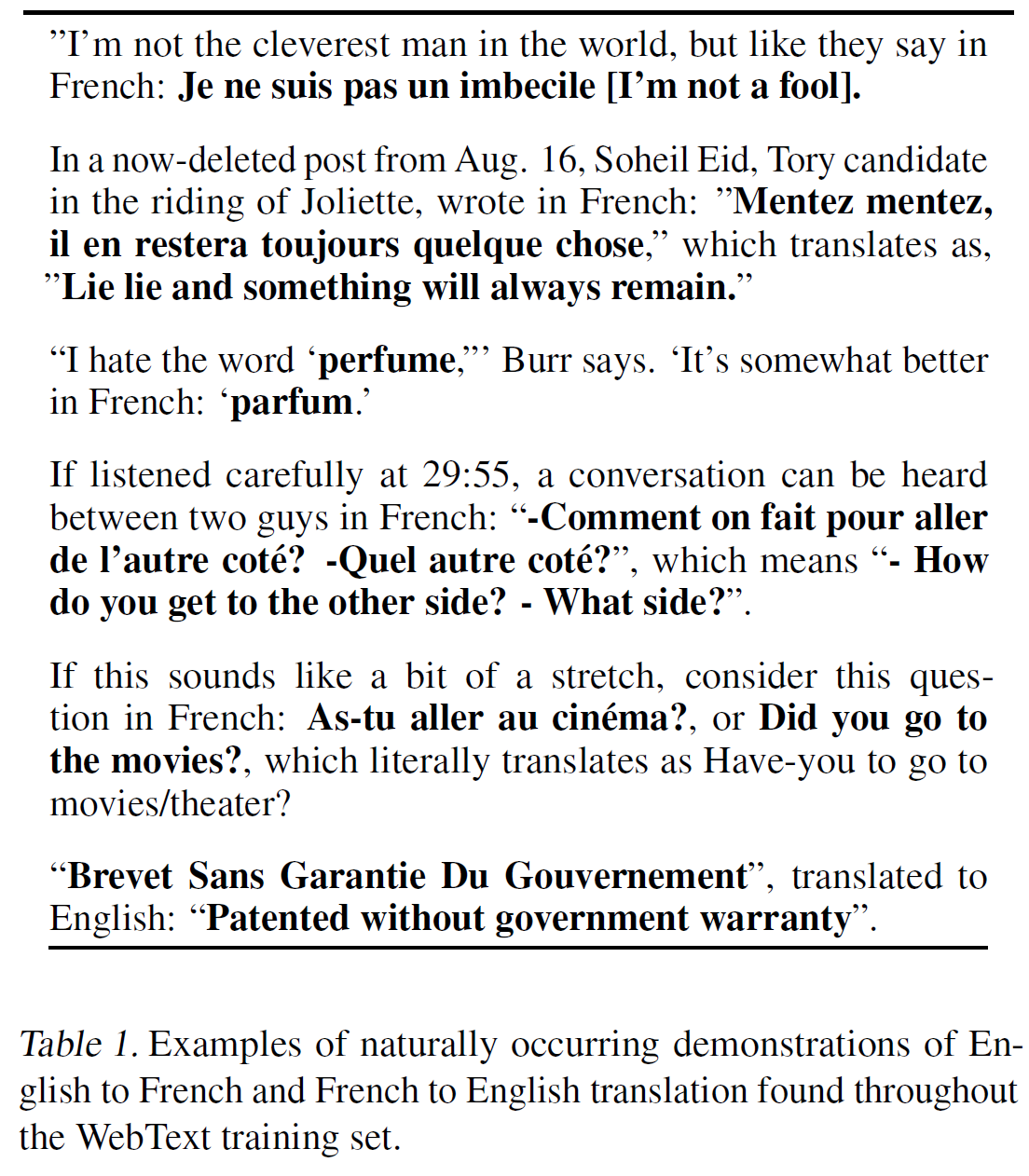

- 그림 2.1과 같이, 일반적인 데이터 집합의 경우, 예를 들어 영어 문장과 프랑스어 번역과 같은 맥락과 원하는 완료가 있다.

- 그리고 거의 찍지 않는 것은 K개 예시로 문맥과 완성의 예를 주고, 그 다음 문맥의 마지막 예를 하나 제시함으로써 작동하며, 모델은 완성을 제공할 것으로 예상된다.

- 모델 컨텍스트 창(nctx = 2048)에 적합할 수 있는 예제를 일반적으로 10 ~ 100 범위에서 K를 설정한다.

- Few-Shot의 주요 장점은 작업별 데이터에 대한 필요성을 크게 줄이고, 크지만 좁은 미세 조정 데이터 집합에서 지나치게 좁은 분포를 학습할 수 있는 잠재력을 줄인다는 것이다.

- 가장 큰 단점은 지금까지 이 방법의 결과가 최첨단 미세 조정 모델보다 훨씬 더 나빴다는 점이다.

- 또한 소량의 작업별 데이터가 여전히 필요하다.

- 이름에서 알 수 있듯이, 언어 모델에 대해 여기서 설명하는 몇 발의 피험은 ML [HYC01, VBL+16]의 다른 맥락에서 사용되는 몇 발의 피험과 관련이 있다.

- 두 가지 모두 광범위한 직무 분포를 기반으로 한 학습(이 경우 사전 교육 데이터에 내포되어 있음)과 새로운 직무에 빠르게 적응하는 것을 포함한다.

- One-Shot (1S)

- 원샷(1S)은 그림 1과 같이 과제에 대한 자연어 설명 외에 하나의 시연만 허용된다는 점을 제외하면 거의 쏘지 않는 것과 같다.

- one-shot을 few-shot and zero-shot으로부터 구분하는 이유는 일부 업무가 인간에게 전달되는 방식과 가장 밀접하게 일치하기 때문이다.

- 예를 들어 인간에게 인간 근로자 서비스(예: Mechanical Turk)에서 데이터 집합을 생성하도록 요청할 때, 그 작업에 대한 하나의 시범을 보이는 것이 일반적이다.

- 대조적으로, 예를 제시하지 않으면 업무의 내용이나 형식을 전달하기가 어려울 때가 있다.

- Zero-Shot (0S)

- 제로샷(0S)은 데모가 허용되지 않는다는 점을 제외하면 원샷과 동일하며, 모델에는 과제를 설명하는 자연어 지령만 주어진다.

- 이 방법은 최대의 편의성, 건전성의 가능성, 거짓 상관관계의 회피(교육 전 데이터의 큰 말뭉치에 걸쳐 매우 광범위하게 발생하지 않는 한)를 제공하지만, 가장 어려운 환경이기도 하다.

- 어떤 경우에는 인간이 사전 예시 없이 업무의 형식을 이해하는 것조차 어려울 수 있기 때문에, 이 설정은 어떤 경우에는 "불공정하게 어려운" 경우도 있다.

- 예를 들어, 누군가에게 "200m 달리기의 세계 기록표를 만들어달라"고 요청한다면, 이 요청은 모호할 수 있는데, 이는 테이블이 어떤 형식을 가져야 하는지 또는 어떤 것을 포함해야 하는지를 정확히 알지 못할 수 있기 때문이다(그리고 세심한 설명에도 불구하고, 원하는 것을 정확히 이해하는 것은 어려울 수 있다).

- 그럼에도 불구하고, 최소한 어떤 설정에서는 제로샷이 인간이 작업을 수행하는 방법에 가장 가까운 경우가 있다.

- 예를 들어, 그림 2.1의 번역 예에서, 인간은 텍스트 명령만으로 무엇을 해야 하는지 알 수 있을 것이다.

- Figure 2.1 shows the four methods using the example of translating English to French.

- We especially highlight the few-shot results as many of them are only slightly behind state-of-the-art fine-tuned models.

- Ultimately, however, one-shot, or even sometimes zero-shot, seem like the fairest comparisons to human performance, and are important targets for future work.

2.1 Model and Architectures

- Sparse Transformer[CGRS19]와 유사하게 Transformer에서 교대로 조밀하고 국소적으로 밴딩된 스파스 트랜스포머[CGRS19]를 사용하는 것을 제외하고, 여기에서 설명한 수정된 초기화, 사전 정규화, 되돌릴 수 있는 토큰화를 포함하여 GPT-2와 동일한 모델과 아키텍처를 사용한다.

- 모델 크기에 대한 ML 성능의 의존성을 연구하기 위해, 우리는 8가지 다른 크기의 모델을 훈련하는데, 그 범위는 3차적으로 1억 2,500만 매개변수에서 1,750억 매개변수까지이며, 마지막은 GPT-3라고 하는 모델이다.

- Previous work [KMH+20] suggests that with enough training data, scaling of validation loss should be approximately a smooth power law as a function of size; training models of many different sizes allows us to test this hypothesis both for validation loss and for downstream language tasks.

- 표 2.1은 당사의 8개 모델의 크기와 아키텍처를 보여준다.

- 여기서 nparams는 trainable parameters의 총 수, nlayer는 총 층수, dmodel은 각 병목층에서의 단위 수(우리는 항상 병목층 크기의 4배인 피드포워드 층을 가지고 있다, dff = 4 d dmodel) 그리고 dhead는 각 주의 헤드의 치수다.

- 모든 모델은 nctx = 2048 토큰의 컨텍스트 창을 사용한다. 노드 간 데이터 전송을 최소화하기 위해 깊이와 폭 치수를 따라 GPU 간에 모델을 분할한다.

- 각 모델의 정밀한 아키텍처 매개변수는 GPU 전체 모델의 배치에서 계산 효율성과 부하 분산을 기반으로 선택된다.

- 이전 연구[KMH+20]에서는 검증 손실은 합리적으로 넓은 범위 내에서 이러한 매개변수에 강하게 민감하지 않음을 시사한다.

2.2 Training Dataset

- Common Crawl dataset을 사용하고 좋은 품질의 데이터를 모으기 위해 다음과 같이 한다.

- (1) we downloaded and filtered a version of CommonCrawl based on similarity to a range of high-quality reference corpora,

- (2) we performed fuzzy deduplication at the document level, within and across datasets, to prevent redundancy and preserve the integrity of our held-out validation set as an accurate measure of overfitting, and

- (3) we also added known high-quality reference corpora to the training mix to augment CommonCrawl and increase its diversity.

2.3 Training Process

- larger models can typically use a larger batch size, but require a smaller learning rate

- To train the larger models without running out of memory, we use a mixture of model parallelism within each matrix multiply and model parallelism across the layers of the network.

- All models were trained on V100 GPU’s on part of a high-bandwidth cluster provided by Microsoft.

3 Results

4 Measuring and Preventing Memorization Of Benchmarks

5 Limitations

- 1) 첫째, GPT-3의 강력한 양적·질적 개선에도 불구하고, 특히 직전의 GPT-2에 비해 여전히 텍스트 합성이나 여러 NLP 과제에서 눈에 띄는 약점이 있다.

- 텍스트 합성에서, 비록 전체적으로 품질이 높지만, GPT-3 샘플은 여전히 문서 수준에서 의미론적으로 자신을 반복하고, 충분히 긴 구절에 대해 일관성을 잃기 시작하고, 스스로 모순되며, 때로는 비순차적인 문장이나 단락을 포함하기도 한다.

- repeat themselves semantically at the document level

- start to lose coherence over sufficiently long passages

- contradict themselves

- occasionally contain non-sequitur sentences or paragraphs.

- 텍스트 합성에서 GPT-3의 한계와 강점을 더 잘 이해할 수 있도록 500 개의 선별되지 않은 무조건 샘플 모음을 릴리스합니다.

- 이산 언어 작업 영역 내에서, 우리는 비공식적으로 GPT-3가 이 도메인을 테스트하는 일부 데이터셋(PIQA[BZB+19] 등)에서 잘 수행되었음에도 불구하고 "common sense physics"에 특별한 어려움을 겪고 있는 것 같다는 것을 알아챘다.

- 구체적으로 GPT-3는 "If I put cheese into the fridge, will it melt?"라는 유형의 질문으로 어려움을 겪고 있다.

- 정량적으로, GPT-3의 컨텍스트 내 학습 성과는 제3절에 기술된 바와 같이 벤치마크 제품군에서 주목할 만한 차이를 가지고 있다.

- 특히 두 단어가 문장에서 같은 방식으로 사용되는지, 한 문장이 다른 문장(WIC와 ANLI)을 암시하는지 등 일부 "comparison" 작업에서 one-shot이나 심지어 few-shot을 평가했을 때, 읽기 이해 작업의 하위 집합에서 우발적으로 행동하는 것보다 거의 도움이 되지 않는다.

- 이는 GPT-3가 다른 많은 작업에서 몇 발의 강력한 성능을 보인 것을 감안하면 특히 놀라운 일이다.

- 2) GPT-3는 몇 가지 구조적 및 알고리즘적 한계를 가지고 있으며, 이는 위의 문제 중 일부를 설명할 수 있다.

- 우리는 autoregressive 언어 모델에서 컨텍스트 내 학습 행동을 탐구하는데 초점을 맞췄다.

- 왜냐하면 그것은 이 모델 클래스의 샘플과 계산 가능성 모두에 대해 간단하기 때문이다.

- 결과적으로 우리의 실험은 양방향 구조나 denoising과 같은 다른 훈련 목표를 포함하지 않는다.

- 이는 표준 언어 모델에 비해 이러한 접근법을 사용할 때 개선된 미세 조정 성능을 문서화한 최근의 많은 문헌과는 현저한 차이점이다[RSR+19].

- 따라서 우리의 설계 결정은 양방향성으로부터 경험적으로 이익을 얻는 직무에서 잠재적으로 더 나쁜 성능의 비용으로 이루어진다.

- 여기에는 빈칸 채우기 작업, 두 가지 내용을 되돌아보고 비교하는 작업, 또는 다시 읽거나 긴 통로를 신중히 고려한 후 매우 짧은 답변을 생성해야 하는 작업이 포함될 수 있다.

- 이것은 WIC (두 문장에서 단어의 사용을 비교하는 것을 포함한다), ANLI (두 문장을 비교하여 다른 문장을 내포하는지 확인하는 것을 포함한다),

- 그리고 여러 읽기 이해 과제 (예: QuAC와 RACE)와 같은 몇 가지 과제에 대해 GPT-3가 뒤처지는 몇 개의 과제에 대해 가능한 설명이 될 수 있다.

- 우리는 또한 과거 문헌에 근거하여 대형 양방향 모델이 GPT-3보다 미세 조정에서 더 강할 것이라고 추측한다.

- GPT-3의 규모로 양방향 모델을 만들거나 양방향 모델이 적거나 제로샷 학습으로 작동하도록 하는 것은 향후 연구에 있어 유망한 방향이며, "양방향 모두 최고"를 달성하는 데 도움이 될 수 있다.

- 본 문서에서 설명한 일반적 접근법의 보다 근본적인 제한 - autoregressive or bidirectional LM과 유사한 모델의 확대는 결국 사전 확보 목표의 한계에 부딪힐 수 있거나 이미 부딪힐 수 있다는 것이다.

- 우리의 현재 목표는 모든 토큰에 균등하게 가중치를 매기고 무엇이 가장 중요하고 무엇이 덜 중요한지에 대한 개념이 부족하다.

- [RRS20] demonstrate benefits of customizing prediction to entities of interest.

- 또한, 자체 감독 목적의 경우, 직무 명세서는 원하는 업무를 예측 문제로 강제하는 것에 의존하는 반면, 궁극적으로 유용한 언어 시스템(예: 가상 보조자)은 단순한 예측보다는 목표 지향적인 행동을 취하는 것으로 더 잘 생각할 수 있다.

- 마지막으로, 큰 사전 검증된 언어 모델은 비디오나 실제의 물리적 상호작용과 같은 경험의 다른 영역에 기반을 두지 않으며, 따라서 세계에 대한 많은 양의 컨텍스트가 부족하다[BHT+20]

- For all these reasons, scaling pure self-supervised prediction is likely to hit limits, and augmentation with a different approach is likely to be necessary.

- 이러한 맥락에서 미래의 방향성을 약속하는 것에는 인간으로부터 객관적인 기능을 배우거나, 강화 학습으로 미세 조정하거나, 지반과 더 나은 세계의 모델을 제공하기 위해 이미지와 같은 추가 촬영장비를 추가하는 것이 포함될 수 있다[CLY+19].

- 언어 모델에 의해 광범위하게 공유되는 또 다른 제한은 사전 교육 동안 샘플 효율성이 떨어진다는 것이다.

- GPT-3는 시험 시간 샘플 효율을 인간(원샷 또는 제로샷)에 가깝게 한 걸음 내딛지만, 사전 훈련 동안 인간이 평생 동안 보는 것보다 훨씬 더 많은 텍스트를 볼 수 있다[Lin20].

- 사전 교육 표본 효율성의 향상은 향후 작업에 중요한 방향이며, 추가 정보를 제공하기 위한 grounding in the physical world 또는 알고리즘 개선에서 나올 수 있다.

- GPT-3의 소수점 학습과 관련된 한계 또는 최소한 불확실성은 소수의 소수점 학습이 실제로 추론 시간에 "처음부터" 새로운 과제를 학습하는지 또는 단순히 훈련 중에 학습한 과제를 인식하고 식별하는지에 대한 모호성이다.

- 이러한 가능성은 시험 시와 정확히 동일한 분포에서 도출된 훈련 세트의 시연에서부터, 동일하지만 다른 형식의 과제를 인식하는 것, QA와 같은 일반 과제의 특정 스타일에 적응하는 것, 완전히 de novo로 기술을 학습하는 것까지 스펙트럼에 존재한다.

- GPT-3가 이 스펙트럼에 있는 경우 작업마다 다를 수 있다.

- 단어들을 뒤죽박죽으로 만들거나 허튼 말을 정의하는 것과 같은 synthetic task는 특히 노보에서 배울 가능성이 높은 반면, 번역은 시험 데이터와 조직과 스타일이 매우 다른 데이터로부터는 가능하지만 사전 연습 중에 분명히 학습되어야 한다.

- 궁극적으로 인간이 처음부터 무엇을 배우는지, 이전의 시위에서 무엇을 배우는지조차 명확하지 않다.

- 사전 교육 중에 다양한 데모를 조직하고 시험 시간에 식별하는 것 조차도 언어 모델의 진보가 될 수 있지만 그럼에도 불구하고 어떻게 few-shot 학습이 작동하는지 정확히 이해하는 것은 향후 연구를 위한 중요한 미개척 방향이다.

- 객관적 기능이나 알고리즘에 관계없이 GPT-3 규모의 모델과 관련된 한계는 추론을 수행하는 데 비용이 많이 들고 불편하다는 것이며, 이는 현재 형태에서 이 규모의 모델의 실제 적용 가능성에 대한 어려움을 나타낼 수 있다.

- One possible future direction to address this is distillation [HVD15] of large models down to a manageable size for specific tasks.

- GPT-3와 같은 대형 모델에는 매우 광범위한 기술이 포함되어 있는데, 대부분 특정 작업에 필요하지 않아 원칙적으로 공격적인 증류가 가능할 수 있음을 시사한다.

- 증류는 일반적으로 [LHCG19a]에 잘 설명되어 있지만 수천억 개의 매개변수 규모에서 시도되지 않았다.

- 새로운 도전과 기회는 이 크기의 모델에 적용하는 것과 관련이 있을 수 있다.

- Finally, GPT-3 shares some limitations common to most deep learning systems

- its decisions are not easily interpretable

- it is not necessarily well-calibrated in its predictions on novel inputs as observed by the much higher variance in performance than humans on standard benchmarks,

- and it retains the biases of the data it has been trained on.

- 이 마지막 문제(biases in the data that may lead the model to generate stereotyped(고정관념) or prejudiced(편견있는) content)는 사회적 관점에서 특별한 관심사가 되며, 다음 섹션의 광범위한 영향(섹션 6)의 다른 문제와 함께 논의될 것이다.

6 Broader Impacts

7 Related Work

8 Conclusion

- 우리는 zero-shot, one-shot, few-shot settings에서 많은 NLP 작업과 벤치마크에서 강력한 성능을 보이는 1,750억 개의 파라미터 언어 모델을 제시하였다.

- 어떤 경우에는 첨단 정밀 분석 시스템의 성능과 거의 일치하는 동시에 고품질 샘플 생성과 즉각적으로 정의된 작업에서 강력한 질적 성능을 제공하는 경우도 있다.

- 우리는 fine-tuning없이 대략적으로 성능에서 확장의 예측가능한 trends을 문서화했다.

- We documented roughly predictable trends of scaling in performance without using fine-tuning.

- 우리는 또한 이 모델의 사회적 영향에 대해 토론했다.

- 많은 한계와 약점에도 불구하고, 이러한 결과는 매우 큰 언어 모델이 적응 가능한 일반 언어 시스템의 개발에 중요한 요소가 될 수 있음을 시사한다.

Reference

댓글

댓글 쓰기