NL-177, Training language models to follow instructions with human feedback, OpenAI 2022.03

Abstract

- 언어 모델을 더 크게 만든다고 해서 본질적으로 사용자의 의도를 더 잘 따르는 것은 아닙니다.

- 예를 들어 대규모 언어 모델은 untruthful, toxic, 단순히 사용자에게 도움이 되지 않는 출력을 생성할 수 있습니다.

- 즉, 이러한 모델은 사용자와 일치하지 않습니다.

- 이 논문에서는 사람의 피드백을 통해 미세 조정하여 다양한 작업에 대한 사용자 의도에 맞게 언어 모델을 정렬하는 방법을 보여줍니다.

- OpenAI API를 통해 제출된 일련의 labeler-written prompts 및 프롬프트로 시작하여 supervised learning을 사용하여 GPT-3을 미세 조정하는 데 사용하는 원하는 모델 동작의 labeler demonstrations의 데이터 세트를 수집합니다.

- 그런 다음 모델 출력의 순위 데이터 세트를 수집하여 사람의 피드백에서 강화 학습을 사용하여 이 지도 모델을 추가로 미세 조정하는 데 사용합니다.

- 결과 모델을 InstructGPT라고 합니다.

- 프롬프트 분포에 대한 사람의 평가에서 1.3B 매개변수 InstructGPT 모델의 출력은 매개변수가 100배 적음에도 불구하고 175B GPT-3의 출력보다 선호됩니다.

- 이게 연구 결과라고 봐도 될듯

- 또한 InstructGPT 모델은 공개 NLP 데이터 세트에서 performance regressions를 최소화하면서 신뢰성이 향상되고 유해한 출력 생성이 감소함을 보여줍니다.

- InstructGPT는 여전히 간단한 실수를 범하지만, 우리의 결과는 사람의 피드백을 통한 미세 조정이 언어 모델을 사람의 의도에 맞추는 유망한 방향임을 보여줍니다.

1 Introduction

- Large language models(LM)은 작업의 몇 가지 예를 입력으로 제공하여 다양한 자연어 처리(NLP) 작업을 수행하도록 "prompted"될 수 있습니다.

- 그러나, 이러한 모델들은 사실을 꾸며내기, biased or toxic text 생성하기, 단순히 user 지침을 따르지 않는 것과 같이 의도하지 않은 행동을 표현하는 경우가 많습니다.

- 일반적인 LM의 문제점들

- 이는 최근 많은 large LMs에서 사용되는 language modeling objective가 (predicting the next token on a webpage from the internet) “follow the user’s instructions helpfully and safely” 라는 objective와 다르기 때문이다.

- 즉, 지금은 단순히 단순 토큰 prediction하도록 학습하는데, 이는 user의 지침을 유용하게, 안전하게 따르는 것과는 다른 것이라서 발생한 문제라는 것

- 그래서, 우리는 language modeling objecitve가 잘못정렬되었다고 말한다.

- 이러한 의도하지 않은 동작을 방지하는 것은 수백 개의 애플리케이션에서 배포 및 사용되는 언어 모델에 특히 중요합니다.

- 우리는 사용자의 의도에 따라 작동하도록 언어 모델을 훈련하여 언어 모델을 정렬하는 작업을 진행합니다.

- 여기에는 지침을 따르는 것과 같은 명시적인 의도와 진실을 유지하고 편향되지 않거나 신뢰할만한 것과 같은 함축적인 의도가 모두 포함됩니다.

- Askell(2021)의 언어를 사용하여 우리는 language models이 도움이 되고(사용자가 작업을 해결하는 데 도움이 되어야 함), 정직하고(정보를 조작하거나 사용자를 오도해서는 안 됨), 무해(물리적, 사람이나 환경에 대한 심리적 또는 사회적 피해)하기를 원한다.

- 섹션 3.6에서 이러한 기준의 평가에 대해 자세히 설명합니다.

- We focus on fine-tuning approaches to aligning language models.

- 즉 LM을 어떻게 사람의 지침대로 학습을 할 것인가가 이 논문의 목표

- 구체적으로 인간의 피드백을 통한 강화 학습(RLHF; Christiano et al., 2017; Stiennon et al., 2020)을 사용하여 GPT-3를 미세 조정하여 광범위한 종류의 서면 지침을 따르도록 합니다(그림 2 참조).

- 이 기술은 human preferences를 reward signal로 사용하여 모델을 fine-tune합니다.

- (1) 우리는 먼저 40명의 계약자로 구성된 팀을 고용하여 스크리닝 테스트의 성과에 따라 데이터에 레이블을 지정합니다 (자세한 내용은 섹션 3.4 및 부록 B.1 참조).

- (2) 그런 다음 OpenAI API에 제출된 (대부분 영어) 프롬프트와 일부 labeler-written prompts에서 desired output behavior에 대한 사람이 작성한 demonstrations 데이터 세트를 수집하고 이를 사용하여 supervised learning 기준선을 교육합니다.

- 예) prompt: 6살 아이에게 달착륙을 설명하다

- --> 원하는 출력: 사람들이 달에 갔었다..

- 위와 같이 주어진 prompt에 대해 사람이 원하는 출력 행동을 작성하고 이로 supervised learning을 한 것이 베이스라인

- (3) 다음으로 더 큰 API 프롬프트 세트에서 모델의 출력 간에 human-labeled comparisons comparisons 데이터 세트를 수집합니다.

- 그런 다음 이 데이터 세트에서 reward model(RM)을 훈련하여 레이블러가 선호하는 모델 출력을 예측합니다.

- 즉, 특정 prompt에 대해 여러 모델을 돌려서, 출력을 여러개 뽑느다.

- 출력간의 좋은 순위를 랭킹매긴다.

- 모델한테 어떤 출력이 상대적으로 좋은지 학습하게 한다.

- (4) 마지막으로 이 RM을 reward function로 사용하고 supervised learning baseline을 미세 조정하여 PPO 알고리즘을 사용하여 이 보상을 최대화합니다(Schulman et al., 2017).

- 즉 (3)에서 학습된 reward model로 각 입력에 대해 reward을 측정한다.

- 그리고 이 reward가 최대화되도록 모델 학습을 PPO로 시킨다.

- We illustrate this process in Figure 2.

- 이 절차는 GPT-3의 동작을 "인간 가치"라는 더 넓은 개념이 아니라 특정 그룹의 사람들(대부분 레이블러 및 연구원)의 명시된 선호도에 맞춥니다.

- 이에 대해서는 섹션 5.2에서 더 논의합니다.

- 결과 모델을 InstructGPT라고 합니다.

- 우리는 주로 레이블러가 테스트 세트에서 모델 출력의 품질을 평가하도록 하여 모델을 평가합니다.

- 이 테스트 세트는 보류된 customers(훈련 데이터에 표시되지 않음)의 프롬프트로 구성됩니다.

- 즉 새로운 데이터 및 새로운 프롬프트에 대해 평가를 한다.

- 또한 다양한 공개 NLP 데이터 세트에 대한 자동 평가를 수행합니다.

- 세 가지 모델 크기(1.3B, 6B 및 175B 매개변수)를 교육하고 모든 모델은 GPT-3 아키텍처를 사용합니다.

- Our main findings are as follows:

- Labelers significantly prefer InstructGPT outputs over outputs from GPT-3.

- 테스트 세트에서 매개변수가 100배 이상 적음에도 불구하고 1.3B 매개변수 InstructGPT 모델의 출력이 175B GPT-3의 출력보다 선호됩니다.

- 이러한 모델은 아키텍처가 동일하며 InstructGPT가 인간 데이터에 대해 미세 조정된다는 사실만 다릅니다.

- 이 결과는 지침을 더 잘 따르도록 하기 위해 GPT-3에 few-shot prompt 프롬프트를 추가한 경우에도 마찬가지입니다.

- 175B InstructGPT의 출력은 시간의 85 ± 3%에서 175B GPT-3 출력보다 선호되고 시간의 71 ± 4%는 few-shot 175B GPT-3보다 선호됩니다.

- 또한 InstructGPT 모델은 라벨러에 따라 보다 적절한 출력을 생성하고 instruction의 명시적 제약을 보다 안정적으로 따릅니다.

- InstructGPT models show improvements in truthfulness over GPT-3.

- TruthfulQA 벤치마크에서 InstructGPT는 GPT-3보다 약 2배 더 truthful되고 informative 답변을 생성합니다.

- 우리의 결과는 GPT-3에 대해 적대적으로 선택되지 않은 질문의 하위 집합에 대해서도 동일하게 강력합니다.

- 출력에 입력에 없는 정보가(예: summarization and closed-domain QA) 포함되어서는 안 되는 API prompt distribution의 "closed-domain" 작업에서 InstructGPT 모델은 입력에 없는 정보를 GPT-3의 절반 정도 자주 구성합니다(21% vs. 41% hallucination).

- 즉, InstructGPT가 close-domain에서 모델의 입력을 좀 더 활용한다?

- InstructGPT shows small improvements in toxicity over GPT-3, but not bias.

- toxicity을 측정하기 위해 RealToxicityPrompts 데이터 세트를 사용하고 automatic 및 human 평가를 모두 수행합니다.

- InstructGPT 모델은 존중하라는 메시지가 표시될 때 GPT-3보다 약 25% 적은 toxic 출력을 생성합니다.

- InstructGPT는 Winogender 및 CrowSPairs 데이터 세트에서 GPT-3보다 크게 개선되지 않습니다.

- We can minimize performance regressions on public NLP datasets by modifying our RLHF fine-tuning procedure.

- RLHF fine-tuning 중에 특정 공개 NLP 데이터 세트, 특히 SQuAD, DROP, HellaSwag 및 WMT 2015 프랑스어에서 영어로의 번역에서 GPT-3에 비해 performance regressions를 관찰합니다.

- 이것은 우리의 alignment procedure가 우리가 관심을 가질 수 있는 특정 작업에 대한 낮은 성능을 희생하기 때문에 "alignment tax"의 예입니다.

- PPO 업데이트와 log likelihood of the pretraining distribution (PPO-ptx)를 높이는 업데이트를 혼합하여 labeler preference scores를 손상시키지 않고 이러한 데이터 세트의 performance regressions를 크게 줄일 수 있습니다.

- 즉, RLHF로 학습하면, 일반적으로 많이들 하는 NLP task들(squad, wmt 등)에 대해서 성능 하락을 할 수 있지만, mixing PPO updates with updates that increase the log likelihood of the pretraining distribution을 통해 성능을 손상시키지 않을 수 있다.

- Our models generalize to the preferences of “held-out” labelers that did not produce any training data.

- 우리 모델의 일반화를 테스트하기 위해 held-out 레이블러로 preliminary experiment을 수행하고 훈련된 레이블러와 거의 동일한 속도로 GPT-3의 출력보다 InstructGPT 출력을 선호한다는 사실을 발견했습니다.

- 즉 학습된 레이블러가 아닌, 다른 레이블러로 평가해도 InstructGPT > GPT3 였다.

- 그러나 이러한 모델이 더 광범위한 사용자 그룹에서 어떻게 수행되는지, 그리고 인간이 원하는 행동에 대해 동의하지 않는 입력에서 어떻게 수행되는지 연구하려면 더 많은 작업이 필요합니다.

- Public NLP datasets are not reflective of how our language models are used.

- 우리는 human preference data(예: InstructGPT)에 대해 fine-tuned GPT-3과 public NLP 작업의 두 가지 다른 컴파일에서 미세 조정된 GPT-3를 비교합니다.

- FLAN 및 T0(특히 T0++ 변형).

- 이러한 데이터 세트는 각 작업에 대한 natural language instructions과 결합된 다양한 NLP 작업으로 구성됩니다.

- API prompt distribution에서 FLAN 및 T0 모델은 SFT 기준보다 약간 낮은 성능을 보였고 라벨러는 이러한 모델보다 InstructGPT를 상당히 선호했습니다(InstructGPT는 26.8 ±2% 및 29.8 ± T0 및 FLAN 버전의 경우 각각 2%).

- human preference data로 InstructGPT vs FALN or T0을 학습하여 비교 해보니, instructGPT가 더 좋았다.

- InstructGPT models show promising generalization to instructions outside of the RLHF finetuning distribution.

- 우리는 InstructGPT의 capabilities을 질적으로 조사하고 미세 조정 배포에서 이러한 지침이 매우 드물지만 코드 요약 지침을 따르고 코드에 대한 질문에 답하며 때로는 다른 언어의 지침을 따를 수 있음을 발견했습니다.

- 반대로 GPT-3는 이러한 작업을 수행할 수 있지만 더 신중한 프롬프트가 필요하며 일반적으로 이러한 도메인의 지침을 따르지 않습니다.

- 이 결과는 우리 모델이 "지침을 따르는 것"이라는 개념을 일반화할 수 있음을 시사하기 때문에 흥미진진합니다.

- 그들은 직접적인 감독 신호를 거의 받지 못하는 작업에 대해서도 어느 정도 정렬을 유지합니다.

- 즉 사람 지침을 따르는 느낌으로 모델이 학습되었으며, 가끔 다른 도메인 (코드 요약 등)에 대해서도 그 도메인의 지침을 따르도록 학습이 되었다는 것이다.

- 하지만 일반적인 케이스는 아니고, 더욱 신중한 프롬프트가 필요하다.

- 또한 지침대로 학습되지 않은 테스크들에서도 alignment가 유지되었다고 한다.

- InstructGPT still makes simple mistakes.

- 예를 들어, InstructGPT는 여전히 지침을 따르지 못하고, 사실을 구성하고, 간단한 질문에 대해 긴 헤징 답변을 제공하거나, 잘못된 전제가 있는 지침을 감지하지 못할 수 있습니다.

- 완벽하지는 않다..

2 Related work

- Research on alignment and learning from human feedback.

- 우리는 모델을 인간의 의도, 특히 인간 피드백으로부터의 강화 학습(RLHF)에 맞추는 이전 기술을 기반으로 합니다.

- 원래는 시뮬레이션 환경과 Atari 게임에서 간단한 로봇을 훈련시키기 위해 개발되었지만 최근에는 텍스트를 요약하기 위한 미세 조정 언어 모델에 적용되었습니다.

- 이 작업은 대화, 번역, 의미 구문 분석, 스토리 생성, 검토 생성 및 증거 추출과 같은 영역에서 보상으로 사람의 피드백을 사용하는 유사한 작업의 영향을 받습니다.

- Madaan(2022)은 서면 인간 피드백을 사용하여 프롬프트를 강화하고 GPT-3의 성능을 개선합니다.

- RL을 표준 사전과 함께 사용하여 텍스트 기반 환경에서 에이전트를 정렬하는 작업도 있었습니다.

- 우리의 작업은 언어 작업의 광범위한 분포에 대한 언어 모델을 정렬하기 위해 RLHF를 직접 적용한 것으로 볼 수 있습니다.

- 언어 모델이 정렬된다는 것이 무엇을 의미하는지에 대한 질문도 최근 주목을 받고 있습니다.

- Kenton(2021)은 유해한 콘텐츠 생성 및 잘못 지정된 게임 목표를 포함하여 정렬 불량으로 인해 발생하는 LM의 행동 문제를 분류합니다.

- concurrent work에서 Askell(2021)은 얼라인먼트 연구를 위한 테스트베드로 언어 보조원을 제안하고 몇 가지 간단한 기준선과 그 스케일링 속성을 연구합니다.

- Training language models to follow instructions.

- 우리의 작업은 또한 언어 모델의 교차 작업 일반화에 대한 연구와 관련이 있습니다.

- 여기서 LM은 광범위한 공개 NLP 데이터 세트(일반적으로 적절한 지침이 접두사로 붙음)에서 미세 조정되고 다양한 NLP 작업 세트에서 평가됩니다.

- 이 영역에는 교육 및 평가 데이터, 지침 형식, 사전 교육된 모델의 크기 및 기타 실험 세부 정보가 다른 다양한 작업이 있었습니다.

- 연구 전반에 걸친 일관된 결과는 지침과 함께 다양한 NLP 작업에서 LM을 미세 조정하면 제로 샷 및 소수 샷 설정 모두에서 보류 작업에 대한 다운스트림 성능이 향상된다는 것입니다.

- 또한 모델이 시뮬레이션된 환경에서 탐색하기 위해 자연 언어 지침을 따르도록 훈련되는 탐색을 위한 지침에 대한 관련 작업 라인도 있습니다.

- Evaluating the harms of language models.

- 언어 모델의 동작을 수정하는 목표는 이러한 모델이 실제 세계에 배포될 때 이러한 모델의 피해를 완화하는 것입니다.

- 이러한 위험은 광범위하게 문서화되었습니다.

- 언어 모델은 편향된 출력을 생성하고, 개인 데이터를 유출하고, 잘못된 정보를 생성하고, 악의적으로 사용될 수 있습니다.

- 철저한 검토를 위해 독자를 Weidinger(2021)로 안내합니다.

- 특정 도메인에 언어 모델을 배포하면 예를 들어 대화 시스템에서 새로운 위험과 문제가 발생합니다.

- 특히 독성, 고정관념 및 사회적 편견과 관련하여 이러한 피해를 구체적으로 평가하기 위한 벤치마크를 구축하는 것을 목표로 하는 초기 단계이지만 성장하고 있는 분야가 있습니다.

- LM 행동에 대한 선의의 개입이 부작용을 일으킬 수 있기 때문에 이러한 문제에 대해 상당한 진전을 이루는 것은 어렵습니다.

- 예를 들어, LM의 독성을 줄이려는 노력은 교육 데이터의 편견적인 상관 관계로 인해 과소 대표 그룹의 텍스트를 모델링하는 능력을 감소시킬 수 있습니다.

- Modifying the behavior of language models to mitigate harms.

- 언어 모델의 생성 동작을 변경하는 방법에는 여러 가지가 있습니다.

- Solaiman 및 Dennison(2021)은 작은 value-targeted 데이터 세트에서 LM을 미세 조정하여 질문 응답 작업에서 이러한 값을 준수하는 모델의 능력을 향상시킵니다.

- Ngo(2021)는 언어 모델이 연구원이 작성한 트리거 문구 세트를 생성할 조건부 가능성이 높은 문서를 제거하여 사전 훈련 데이터 세트를 필터링합니다.

- 이 필터링된 데이터 세트에서 교육을 받으면 LM은 언어 모델링 성능이 약간 감소하는 대신 유해한 텍스트를 덜 생성합니다.

- Xu(2020)는 데이터 필터링, 생성 중 특정 단어 또는 n-gram 차단, 안전 관련 제어 토큰, 인간 참여 루프(Human-in-theloop) 데이터 수집 등 다양한 접근 방식을 사용하여 챗봇의 안전성을 개선합니다.

- LM에 의해 생성된 편향을 완화하기 위한 다른 접근 방식은 단어 임베딩 정규화, 데이터 확대, 민감한 토큰에 대한 분포를 보다 균일하게 만들기 위한 null 공간 투영, 다른 목적 함수 또는 인과 매개 분석을 사용합니다.

- 또한 두 번째(일반적으로 더 작은) 언어 모델을 사용하여 언어 모델 생성을 조정하는 작업이 있으며 이 아이디어의 변형이 언어 모델 독성을 줄이기 위해 적용되었습니다.

3 Methods and experimental details

3.1 High-level methodology

- 우리의 방법론은 Ziegler(2019)와 Stiennon(2020)의 방식을 따르며, 이들은 스타일 연속 및 요약 영역에 적용했습니다.

- 우리는 pretrained language model, 모델이 정렬된 출력을 생성하기를 원하는 distribution of prompts, 훈련된 인간 라벨러 팀으로 시작합니다(자세한 내용은 섹션 3.4 참조).

- 그런 다음 다음 세 단계를 적용합니다(그림 2).

- Step 1: Collect demonstration data, and train a supervised policy.

- 라벨러는 입력 프롬프트 분포에서 원하는 행동의 demonstrations를 제공합니다(이 분포에 대한 자세한 내용은 섹션 3.2 참조).

- 그런 다음 supervised learning을 사용하여 이 데이터에서 pretrained GPT-3 모델을 미세 조정합니다.

- Step 2: Collect comparison data, and train a reward model.

- 우리는 라벨러가 주어진 입력에 대해 선호하는 출력을 가리키는 모델 출력 간의 비교 데이터 세트를 수집합니다.

- 그런 다음 reward model을 훈련하여 인간이 선호하는 출력을 예측합니다.

- Step 3: Optimize a policy against the reward model using PPO.

- RM의 출력을 scalar reward으로 사용합니다.

- 우리는 PPO 알고리즘을 사용하여 이 reward을 최적화하기 위해 supervised policy을 미세 조정합니다 (Schulman et al., 2017).

- 여기서 RM과 policy 모델은 똑같인 pretrained GPT-3을 초기상태로 fine-tuned하는 거겠지?

- 2단계와 3단계는 계속해서 반복할 수 있습니다.

- 새로운 RM을 교육한 다음 새 policy을 교육하는 데 사용되는 현재 best policy에 대해 더 많은 비교 데이터가 수집됩니다.

- 실제로 대부분의 비교 데이터는 supervised policies에서 가져오며 일부는 PPO policies에서 가져옵니다.

- 비교 데이터를 가져오려면, 여러 모델의 출력을 활용해야하는데, 일부는 step1에서 학습된 모델, 일부는 이전 step3에서 학습된 모델을 활용한다는 것?

- 여기서 이전 step3의 모델이란 것은 step2-3이 반복적으로 수행되는데, 이전 step3의 결과물이다.

- 첫 번째 step2을 할 때는 사람이 만든 데이터를 사용

- 아무튼, step2로 reward 모델 강화하고 step3로 PPO policy강화 하는 반복적 작업

3.2 Dataset

- 프롬프트 데이터 세트는 주로 OpenAI API에 제출된 text prompts, 특히 Playground 인터페이스에서 이전 버전의 InstructGPT 모델(demonstration 데이터의 하위 집합에 대한 supervised learning을 통해 훈련됨)을 사용하는 텍스트 프롬프트로 구성됩니다.

- 즉, 이전 InstructGPT 버전의 모델을 사용한 유저들의 text prompts들을 활용했다는 것

- Playground를 사용하는 고객은 InstructGPT 모델이 사용될 때마다 반복 알림을 통해 추가 모델을 교육하는 데 데이터를 사용할 수 있다는 정보를 받았습니다.

- 이 논문에서는 프로덕션에서 API를 사용하는 고객의 데이터를 사용하지 않습니다.

- 우리는 long common prefix를 공유하는 프롬프트를 확인하여 추론적으로 프롬프트를 중복 제거하고 프롬프트 수를 사용자 ID당 200개로 제한합니다.

- 또한 사용자 ID를 기반으로 훈련, 검증 및 테스트 분할을 생성하므로 검증 및 테스트 세트에는 데이터가 훈련 세트에 있는 사용자의 데이터가 포함되지 않습니다.

- 모델이 잠재적으로 민감한 고객 세부 정보를 학습하지 않도록 하기 위해 개인 식별 정보(PII)에 대한 교육 분할의 모든 프롬프트를 필터링합니다.

- 최초의 InstructGPT 모델을 교육하기 위해 라벨러에게 프롬프트를 직접 작성하도록 요청했습니다.

- 맨 처음에는 라벨러가 프롬프트 작성 (step 2)

- 이는 프로세스를 부트스트랩하기 위해 지침과 같은 프롬프트의 초기 소스가 필요했고 이러한 종류의 프롬프트는 API의 일반 GPT-3 모델에 자주 제출되지 않았기 때문입니다.

- We asked labelers to write three kinds of prompts:

- Plain:

- 우리는 작업의 다양성을 보장하면서 라벨러에게 임의의 작업을 제안하도록 요청합니다.

- Few-shot:

- 우리는 레이블 지정자에게 지침과 해당 instruction에 대한 여러 query/response 쌍을 제시하도록 요청합니다.

- 예를 들어, instruction은 "트윗에 대한 감정 제공"이고 query는 트윗이고 response은 "긍정적" 또는 "부정적"일 수 있습니다.

- 그런 다음 Brown(2020)에서와 같이 few-shot prompts로 format을 지정할 수 있습니다.

- K 쿼리-응답 쌍을 사용하여 컨텍스트에서 다른 K-1을 사용하여 K 학습예제를 만듭니다.

- K개의 예제가 있으면, K-1개는 context로 사용 1개는 학습예제로 사용.

- 학습예제로 사용할 q-r쌍이 K개일 수 있으니까, 결국 K개의 학습예제가 만들어짐.

- User-based:

- OpenAI API에 대한 애플리케이션에 명시된 여러 사용 사례가 있습니다.

- 라벨러에게 이러한 사용 사례에 해당하는 프롬프트를 제시하도록 요청했습니다.

- 이러한 프롬프트에서 fine-tuning 절차에 사용되는 세 가지 데이터 세트를 생성합니다.

- (1) SFT 모델을 교육하는 데 사용되는 labeler demonstrations가 포함된 SFT 데이터 세트, (supervised fine-tuning?)

- (2) RM 데이터 세트, RM 교육에 사용되는 모델 출력의 레이블러 순위 지정 및 (reward-model)

- (3) RLHF 미세 조정을 위한 입력으로 사용되는 사람 레이블이 없는 PPO 데이터 세트.

- SFT 데이터 세트에는 약 13,000개의 교육 프롬프트(API 및 레이블러 작성)가 포함되어 있고, RM 데이터 세트에는 33,000개의 교육 프롬프트(API 및 레이블러 작성)가 있으며, PPO 데이터 세트에는 31,000개의 교육 프롬프트(API에서만)가 있습니다.

- 데이터 세트 크기에 대한 자세한 내용은 표 6에 나와 있습니다.

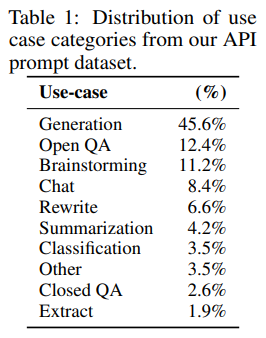

- 데이터 세트의 구성을 이해하기 위해 표 1에는 계약자가 레이블을 지정한 API 프롬프트(특히 RM 데이터 세트)의 사용 사례 범주 분포가 나와 있습니다.

- 대부분의 use-cases는 classification 또는 QA 보다는 generative입니다.

- 우리는 또한 표 2에 몇 가지 예시적인 프롬프트(InstructGPT 모델에 제출된 프롬프트의 종류를 모방하기 위해 연구자가 작성한)를 보여줍니다.

- 부록 A에서 데이터 세트에 대한 자세한 내용을 제공합니다.

- 자세한건 부록 A 참고

3.3 Tasks

- Our training tasks are from two sources:

- (1) 라벨러가 작성한 프롬프트 데이터 세트

- (2) API의 초기 InstructGPT 모델에 제출된 프롬프트 데이터 세트(표 6 참조).

- 이러한 프롬프트는 매우 다양하며 generation, question answering, 대화, 요약, 추출 및 기타 자연어 작업을 포함합니다(표 1 참조).

- 데이터 세트는 96% 이상이 영어이지만 섹션 4.3에서는 모델이 다른 언어로 된 지침에 응답하고 코딩 작업을 완료하는 능력도 조사합니다.

- 각 자연어 프롬프트에 대해 작업은 자연어 명령(예: "현명한 개구리에 대한 이야기 쓰기")을 통해 직접 지정되는 경우가 가장 많지만 몇 가지 예를 통해 간접적으로 지정될 수도 있습니다.

- (예: 개구리 이야기의 두 가지 예를 제공하고 모델이 새 이야기를 생성하도록 유도) 또는 암시적 연속(예: 개구리에 대한 이야기의 시작 제공)

- 각각의 경우에 우리는 라벨러에게 프롬프트를 작성한 사용자의 의도를 추론하기 위해 최선을 다하고 작업이 매우 불분명한 입력을 건너뛰도록 요청합니다.

- 또한 라벨링 담당자는 응답의 진실성과 같은 암시적 의도와 편향되거나 독성이 있는 언어와 같은 잠재적으로 유해한 결과를 고려하여 당사가 제공하는 지침(부록 B 참조)과 최선의 판단에 따라 안내합니다.

3.4 Human data collection

- 데모 및 비교 데이터를 생성하고 주요 평가를 수행하기 위해 Upwork 및 ScaleAI를 통해 약 40명의 계약자로 구성된 팀을 고용했습니다.

- summarization 작업에 대한 인간의 선호도 데이터를 수집하는 이전 작업과 비교할 때 우리의 입력은 훨씬 더 광범위한 작업에 걸쳐 있으며 때때로 논란의 여지가 있고 민감한 주제를 포함할 수 있습니다.

- 우리의 목표는 다양한 인구통계 그룹의 선호도에 민감하고 잠재적으로 유해한 출력을 식별하는 데 능숙한 라벨러 그룹을 선택하는 것이었습니다.

- 따라서 이러한 축에 대한 라벨러 성능을 측정하도록 설계된 스크리닝 테스트를 수행했습니다.

- 우리는 이 테스트에서 좋은 성적을 거둔 레이블러를 선택했습니다.

- 선정 절차 및 라벨러 인구 통계에 대한 자세한 내용은 부록 B.1을 참조하십시오.

- training and evaluation 중에 alignment 기준이 충돌할 수 있습니다.

- 예를 들어 사용자가 잠재적으로 유해한 응답을 요청하는 경우입니다.

- training 동안 우리는 사용자에 대한 도움을 우선시합니다(그렇게 하지 않으면 향후 작업에 남겨두는 어려운 설계 결정을 내려야 합니다. 자세한 내용은 섹션 5.4 참조).

- 그러나 최종 평가에서 우리는 레이블러에게 truthfulness(진실성)과 harmlessness(무해성)을 우선시하도록 요청했습니다(이것이 우리가 진정으로 관심을 갖는 것이기 때문입니다).

- Stiennon(2020)에서와 같이 우리는 프로젝트 과정에서 레이블러와 긴밀하게 협력합니다.

- 우리는 프로젝트에 대해 레이블러를 교육하고, 각 작업에 대한 자세한 지침을 작성하고(부록 B.2 참조) 공유 채팅방에서 레이블러 질문에 답변하는 온보딩 프로세스를 가지고 있습니다.

- 우리 모델이 다른 라벨러의 선호도에 얼마나 잘 일반화되는지 확인하기 위한 초기 연구로, 트레이닝 데이터를 생성하지 않는 별도의 라벨러 세트를 고용합니다.

- 이러한 라벨러는 동일한 공급업체에서 제공되지만 스크리닝 테스트를 거치지 않습니다.

- 작업의 복잡성에도 불구하고 애노테이터 간 일치 비율이 상당히 높다는 것을 알 수 있습니다.

- training 라벨러는 72.6 ± 1.5%의 시간 동안 서로 동의하는 반면, held-out 라벨러의 경우 이 수치는 77.3 ± 1.3%입니다.

- 비교를 위해 Stiennon(2020)의 요약 작업에서 researcher-researcher합의는 73 ± 4%였습니다.

3.5 Models

- Brown(2020)의 GPT-3 사전 훈련된 언어 모델부터 시작합니다.

- 이러한 모델은 인터넷 데이터의 광범위한 분포에 대해 교육을 받고 광범위한 다운스트림 작업에 적응할 수 있지만 안좋은 characterized behavior을 가진다.

- 이러한 모델에서 시작하여 세 가지 기술로 모델을 교육합니다.

- (1) Supervised fine-tuning (SFT).

- 우리는 supervised learning을 사용하여 labeler demonstrations에서 GPT-3를 미세 조정합니다.

- 우리는 cosine learning rate decay와 0.2의 residual dropout을 사용하여 16 epoch 동안 훈련했습니다.

- validation 세트의 RM 점수를 기반으로 최종 SFT 모델 선택을 수행합니다.

- 이는 마지막 step을 말하는 듯?

- Wu(2021)와 유사하게 SFT 모델이 1 epoch 이후 validation loss에 대해 과적합되었음을 발견했습니다.

- 첫 번째 step에서 loss 자체는 1 epoch 만에 수렴했었군?

- 그러나 우리는 더 많은 epochs에 대한 훈련이 이러한 과적합에도 불구하고 RM 점수와 인간 선호도 등급 모두에 도움이 된다는 것을 발견했습니다.

- (2) Reward modeling (RM).

- 최종 unembedding 레이어가 제거된 SFT 모델에서 시작하여 프롬프트와 응답을 받아들이고 스칼라 보상을 출력하도록 모델을 훈련했습니다.

- 여기에 RM 구조가 설명되었었군?

- SFT에 이어서 학습이 되는 방법인데, logit이 1-dimension으로 스칼라 reward을 의미함

- 이 논문에서는 많은 컴퓨팅을 절약하기 때문에 6B RM만 사용하고

- 175B RM 훈련이 불안정할 수 있으므로 RL 동안 value function 로 사용하기에 적합하지 않다는 것을 발견했습니다(자세한 내용은 부록 C 참조).

- 즉 최종 instructGPT은 175B 모델일것이나, RM모델은 6B 사이즈.

- 따라서 6B 모델을 SFT하고 이를 reward modeling으로 학습한 것이 reward model이 된다?

- Stiennon(2020)에서 RM은 동일한 입력에 대한 두 모델 출력 간의 비교 데이터 세트에 대해 훈련됩니다.

- 비교를 레이블로 사용하는 cross-entropy loss을 사용합니다.

- rewards의 차이는 human labeler가 한 응답을 다른 응답보다 선호할 로그 확률을 나타냅니다.

- comparison collection 속도를 높이기 위해 순위에 대해 K=4~9개의 응답이 있는 라벨러를 제시합니다.

- K가 뭐지? 앞에서 K개의 예제를 의미한 걸 보아서, 데이터 예제가 4개에서 9개인 경우 레이블러에게 준다?

- 이렇게 하면 레이블 지정자에게 표시되는 각 프롬프트에 대한 KC2(K combination 2) 비교가 생성됩니다.

- 비교는 각 labeling 작업 내에서 매우 상관 관계가 있기 때문에 비교를 하나의 데이터 세트로 단순히 섞으면 데이터 세트에 대한 단일 패스로 인해 보상 모델이 과적합되는 것을 발견했습니다.

- 대신 각 프롬프트의 모든 KC2 비교를 단일 배치 요소로 학습합니다.

- 일케하면, 하나의 프롬프트에 응답을 여러 쌍으로 비교해서 레이블링할 수 있다.

- 이는 각 completion에 대해 RM의 단일 순방향 패스만 필요하고(K completions에 대한 KC2 순방향 패스가 아님) 더 이상 과적합되지 않기 때문에 훨씬 향상된 validation accuracy and log loss을 달성하기 때문에 훨씬 더 계산적으로 효율적입니다.

- 특히 보상 모델의 손실 함수는 다음과 같습니다.

- 1) 여기서 rθ(x, y)는 매개변수 θ가 있는 prompt x 및 completion y에 대한 보상 모델의 스칼라 출력이고, yw는 (yw와 yl의 쌍) 중에서 선호되는 completion이며, D는 인간 비교의 데이터 세트입니다.

- loss(θ)을 낮춘다는 것은, -가 식에 붙어있으니 E뒤의 log(sigma1-simga2)을 키운다는 것이다.

- 즉 yw와 yl이 RM으로 나온 각각의 보상 차이를 키운다는 것

- yw는 yl보다 사람이 봤을 때 더 나은 답변(completion)임.

- 즉 더 나은 답변이 나오도록 RM모델을 학습시키는 것

- 마지막으로, RM 손실은 reward의 shifts에 불변하기 때문에 labeler demonstrations이 RL을 수행하기 전에 평균 점수가 0이 되도록 편향을 사용하여 보상 모델을 정규화합니다.

- 그 예전에 강화학습에서 이 평균치를 0으로 만들면 학습 잘되는 무슨 기법이 있었는데 그거하고 비슷한듯

- Reinforcement learning (RL).

- Stiennon(2020)에 이어 다시 한 번 PPO(Schulman 2017)를 사용하여 환경에서 SFT 모델을 미세 조정했습니다.

- environment은 임의의 고객 프롬프트를 제시하고 프롬프트에 대한 응답을 기대하는 bandit environment입니다.

- 프롬프트와 응답이 주어지면 보상 모델에 따라 결정된 보상을 생성하고 에피소드를 종료합니다.

- 또한 보상 모델의 과도한 최적화를 완화하기 위해 각 토큰의 SFT 모델에서 토큰당 KL 페널티를 추가합니다. (이건 뭔 말이지?, 반복되는 토큰이 나오지 말라는 것인가?)

- value function는 RM에서 초기화됩니다.

- 이러한 모델을 "PPO"라고 합니다.

- 또한 공개 NLP 데이터 세트의 성능 regressions를 수정하기 위해 pretraining gradients를 PPO gradients에 혼합하여 실험합니다.

- We call these models “PPO-ptx.”

- pretraining gradients가 뭐지?

- We maximize the following combined objective function in RL training:

- 여기서 πRLφ는 학습된 RL 정책이고 πSFT는 지도 학습 모델이며 Dpretrain은 pretraining distribution입니다.

- KL reward coefficient β와 pretraining loss coefficient γ는 각각 KL 페널티와 pretraining gradients 기울기의 강도를 제어합니다.

- For "PPO" models, γ is set to 0.

- 식 1에서 학습된 RM 모델로 reward을 추출할 수 있으므로, 이를통해 식 2처럼 학습시키는 것이다.

- 먼저 Dπφ(데이터셋?)에서 prompt x, completion y을 샘플링한다.

- 그 다음, RM으로 reward을 구한다.

- log 텀은 KL 관련 텀이라고 하는걸 보아, πRL과 πSFT사이의 KL distance을 구한 것 같다.

- πRLφ은 우리가 학습할 모델을 말하는 거 같고, πSFT은 fine-tuned된 모델을(step 1) 말하는 것 같다.

- 즉 입력 (x,y)의 reward을 출력할수있도록 πRLφ을(PPO모델) 학습하는데, 이때 SFT와의 거리가 너무 크지 않도록 한다.

- 왜냐하면 objective의 KL텀 앞에 -가 있으므로, KL값이 작아지는게 하는게 되는데, 이를 beta가 컨트롤하게 되는 것.

- 마지막 텀인 Dpretrain에서 샘플링한 πRLφ은 더해주는 것으로 보아, 이 값이 커지게 해야한다.

- 이때 조건이 없는걸 보아, prompt가 첫번째 문장으로 생성되도록 πRLφ을 일부 같이 학습하는 개념으로 보인다.

- 별도로 지정하지 않는 한 이 백서에서 InstructGPT는 PPO-ptx 모델을 참조합니다.

- Baselines.

- PPO 모델의 성능을 SFT 모델 및 GPT-3과 비교합니다.

- 또한 instruction-following mode (GPT-3-prompted)로 '프롬프트'하기 위해 몇 번의 prefix 제공된 경우 GPT-3과 비교합니다.

- 이 prefix는 user-specified instruction 앞에 붙습니다.

- 또한 InstructGPT를 FLAN(Wei 2021) 및 T0(Sanh 2021) 데이터 세트의 미세 조정 175B GPT-3과 비교합니다.

- 둘 다 다양한 NLP 작업으로 구성되며 각 작업에 대한 자연어 지침과 결합됩니다(데이터 세트는 포함된 NLP 데이터 세트 및 사용된 지침 스타일).

- 각각 약 100만 개의 예에서 미세 조정하고 검증 세트에서 가장 높은 보상 모델 점수를 얻는 체크포인트를 선택합니다.

- 자세한 교육 내용은 부록 C를 참조하십시오.

3.6 Evaluation

- 모델이 얼마나 "aligned"되었는지 평가하려면 먼저 이 맥락에서 alignment이 무엇을 의미하는지 명확히 해야 합니다.

- alignment의 정의는 역사적으로 다양한 경쟁 제안과 함께 모호하고 혼란스러운 주제였습니다(Chen 2021; Leike 2018; Gabriel, 2020).

- Leike(2018)에 이어 우리의 목표는 user intentions에 따라 행동하는 모델을 훈련시키는 것입니다.

- 보다 실질적으로, 언어 작업의 목적을 위해 Askell(2021)과 유사한 프레임워크를 사용합니다. 이 프레임워크는 도움이 되고 정직하며 무해한 (helpful, honest, and harmless) 경우 정렬할 모델을 정의합니다.

- 즉, model이 도움되고, 정직하고, 무해하면 align되었다고 한다?

- 도움이(helpful) 되려면 모델이 지침을 따라야 하지만 "Q: {question}\nA:"와 같은 몇 번의 프롬프트 또는 다른 해석 가능한 패턴에서 의도를 추론해야 합니다.

- 주어진 프롬프트의 의도가 불분명하거나 모호할 수 있으므로 라벨러의 판단에 의존하며 주요 측정항목은 라벨러 선호도 등급입니다.

- 그러나 레이블러는 프롬프트를 생성한 사용자가 아니기 때문에 사용자가 실제로 의도한 것과 레이블러가 프롬프트를 읽기만 하여 의도한 것으로 생각한 것과는 차이가 있을 수 있습니다.

- 순전히 생성 모델에서 정직성을(honesty) 측정하는 방법이 불분명합니다.

- 이를 위해서는 모델의 실제 출력을 올바른 출력에 대한 "belief"과 비교해야 하며 모델이 큰 블랙 박스이기 때문에 그 믿음(belief)을 추론할 수 없습니다.

- 대신, 우리는 두 가지 메트릭을 사용하여 진실성(세계에 대한 모델의 진술이 사실인지 여부)을 측정합니다.

- (1) 폐쇄 도메인 작업("hallucinations")에 대한 정보를 구성하는 모델의 경향을 평가하고

- (2) TruthfulQA 데이터 세트 사용(Lin 2021).

- 즉 모델이 거짓말을 사실처럼 말하는지 안하는지를 판단하는게 honesty?

- 말할 필요도 없이 이것은 진실성이 실제로 의미하는 것의 작은 부분만을 포착할 뿐입니다.

- honesty과 마찬가지로 언어 모델의 피해를(harms) 측정하는 것도 많은 어려움을 야기합니다.

- 대부분의 경우 언어 모델의 피해는 출력이 실제 세계에서 어떻게 사용되는지에 따라 다릅니다.

- 예를 들어 독성 출력을 생성하는 모델은 배포된 챗봇의 맥락에서 해로울 수 있지만 더 정확한 독성 탐지 모델을 교육하기 위해 데이터 증강에 사용되는 경우 도움이 될 수도 있습니다.

- 프로젝트 초기에 우리는 라벨러에게 출력물이 '잠재적으로 유해한지(potentially harmful)' 여부를 평가하도록 했습니다.

- 그러나 출력이 궁극적으로 어떻게 사용되는지에 대해 너무 많은 추측이 필요했기 때문에 이를 중단했습니다.

- 특히 우리 데이터는 (프로덕션 사용 사례가 아니라) Playground API 인터페이스와 상호 작용하는 고객으로부터 오기 때문입니다.

- 그냥 단순히, 출력문이 유해한지 아닌지를 판단하기엔, 너무 여러 시나리오가 있고 추측이 난무하기 때문에 이렇게 평가하는건 하다가 말았다

- 따라서 배포된 모델에서 해로울 수 있는 동작의 다양한 측면을 캡처하는 것을 목표로 하는 보다 구체적인 프록시 기준 모음을 사용합니다.

- 우리는 출력물이 고객 지원의 맥락에서 부적합한지, 보호 계층을 폄하하는지, 성적인 내용이나 폭력적인 내용이 포함되어 있는지 레이블 지정자가 평가하도록 합니다.

- 또한 RealToxicityPrompts(Gehman 2020) 및 CrowS-Pairs(Nangia 2020)와 같이 편견과 독성을 측정하기 위한 데이터 세트에 대한 모델을 벤치마킹합니다.

- 구체적인 프롬팅에 대해? 모델 출력이 부적합, 폄하, 성적, 폭력적인 내용이 있는지 레이블링한다.

- 이는 기존의 bias, toxi을 평가하는 오픈 데이터를 참고했다고 한다.

- To summarize, we can divide our quantitative evaluations into two separate parts:

- Evaluations on API distribution.

- 우리의 주요 메트릭은 교육 분포와 동일한 소스에서 나온 보류된 일련의 프롬프트에 대한 인간의 선호도 등급입니다.

- 평가를 위해 API의 프롬프트를 사용할 때 교육에 포함되지 않은 고객의 프롬프트만 선택합니다.

- 그러나 교육 프롬프트는 InstructGPT 모델과 함께 사용하도록 설계되었기 때문에 GPT-3 기준선에 불리할 가능성이 있습니다.

- 따라서 API의 GPT-3 모델에 제출된 프롬프트도 평가합니다.

- 이러한 프롬프트는 일반적으로 '명령을 따르는' 스타일이 아니지만 GPT-3용으로 특별히 설계되었습니다.

- 두 경우 모두 각 모델에 대해 출력이 기본 정책보다 선호되는 빈도를 계산합니다.

- 175B SFT 모델의 성능이 팩 중간에 가깝기 때문에 기준으로 선택합니다.

- 또한 레이블 지정자에게 1-7 Likert scale에서 각 응답의 전반적인 품질을 판단하고 각 모델 출력에 대한 메타데이터 범위를 수집하도록 요청합니다(표 3 참조).

- Evaluations on public NLP datasets.

- 우리는 두 가지 유형의 공개 데이터 세트, 즉 언어 모델 안전성의 측면, 특히 진실성, 독성 및 편향을 캡처하는 데이터 세트와 질문 답변, 독해 및 요약과 같은 기존 NLP 작업에서 제로 샷 성능을 캡처하는 데이터 세트를 평가합니다.

- 또한 RealToxicityPrompts 데이터 세트(Gehman 2020)에 대한 인간의 독성 평가도 수행합니다.

- 모든 샘플링 기반 NLP 작업에 대한 모델의 샘플을 릴리스하고 있습니다.

4 Results

- 이 섹션에서는 섹션 1의 주장에 대한 실험적 증거를 세 부분으로 분류하여 제공합니다.

- results on the API prompt distribution,

- results on public NLP datasets, and qualitative results.

4.1 Results on the API distribution

- 라벨러는 GPT-3의 출력보다 InstructGPT 출력을 상당히 선호합니다.

- 테스트 프롬프트 세트에서 라벨러는 모델 크기 전반에 걸쳐 InstructGPT 출력을 상당히 선호합니다.

- 이러한 결과는 그림 1에 나와 있습니다.

- 우리는 GPT-3 출력이 최악의 성능을 발휘한다는 것을 발견했으며 잘 만들어진 소수 샷 프롬프트(GPT-3(프롬프트됨))를 사용하여 상당한 단계 크기 개선을 얻을 수 있습니다.

- 그런 다음 감독 학습(SFT)을 사용하여 시연에 대한 교육을 통해 마지막으로 PPO를 사용하여 비교 데이터를 학습합니다.

- PPO 중에 사전 학습 믹스에 대한 업데이트를 추가해도 레이블 지정자 기본 설정이 크게 변경되지 않습니다.

- 이득의 규모를 설명하기 위해 직접 비교할 때 175B InstructGPT 출력이 시간의 85 ± 3%에서 GPT-3 출력보다 선호되고 시간의 71 ± 4%가 몇 샷 GPT-3보다 선호됩니다.

- 또한 API의 GPT-3 모델에 제출된 프롬프트에서 평가할 때 결과가 크게 변경되지 않는 것으로 나타났습니다(그림 3 참조).

- PPO-ptx 모델은 모델 크기가 클수록 성능이 약간 더 떨어집니다.

- 그림 4에서 우리는 레이블러가 InstructGPT 출력을 더 많은 구체적인 축을 따라 호의적으로 평가한다는 것을 보여줍니다.

- 구체적으로, GPT-3에 비해 InstructGPT 출력은 고객 지원의 맥락에서 더 적합하고 지침에 정의된 명시적 제약을 더 자주 따르며(예: "답을 2문단 이하로 작성하십시오.") 실패할 가능성이 적습니다.

- 올바른 지시를 완전히 따르고 폐쇄 영역 작업에서 사실을 구성('환각')하는 빈도를 줄입니다.

- 이러한 결과는 InstructGPT 모델이 GPT-3보다 더 안정적이고 제어하기 쉽다는 것을 시사합니다.

- 다른 메타데이터 범주가 API에서 너무 드물게 발생하여 모델 간에 통계적으로 유의미한 차이를 얻을 수 없다는 사실을 발견했습니다.

- 우리의 모델은 교육 데이터를 생성하지 않은 "held-out" 레이블러의 기본 설정으로 일반화됩니다.

- Held-out 레이블러는 교육 데이터를 생성하는 데 사용한 작업자와 비슷한 순위 선호도를 가집니다(그림 3 참조).

- 특히, 버텼던 작업자에 따르면 모든 InstructGPT 모델은 여전히 GPT-3 기준선보다 훨씬 뛰어난 성능을 보입니다.

- 따라서 InstructGPT 모델은 교육 라벨러의 선호도에 단순히 과적합되지 않습니다.

- 우리는 보상 모델의 일반화 기능에서 이에 대한 추가 증거를 봅니다.

- 라벨러를 5개 그룹으로 나누고 5겹 교차 검증(그룹 중 4개에 대한 교육 및 보류 그룹에 대한 평가)을 사용하여 5개의 RM(3개의 다른 시드 포함)을 교육하는 실험을 실행했습니다.

- 이 RM은 홀드 아웃 그룹의 레이블 지정자 선호도를 예측하는 데 69.6 ± 0.9%의 정확도를 가지며, 훈련 세트에서 레이블 지정자의 선호도를 예측하는 정확도는 72.4 ± 0.4%보다 약간 낮습니다.

- Public NLP 데이터 세트는 언어 모델이 사용되는 방식을 반영하지 않습니다.

- 그림 5에서는 InstructGPT를 FLAN 및 T0 데이터 세트에서 미세 조정된 175B GPT-3 기준선과 비교합니다(자세한 내용은 부록 C 참조).

- 우리는 이러한 모델이 잘 선택된 프롬프트가 있는 GPT-3와 동등한 GPT-3보다 우수하고 SFT 기준선보다 더 나쁘다는 것을 발견했습니다.

- 이는 이러한 데이터 세트가 API 프롬프트 배포의 성능을 개선할 만큼 충분히 다양하지 않다는 것을 나타냅니다.

- 일대일 비교에서 우리의 175B InstructGPT 모델 출력은 FLAN 모델 78 ±4% 시간과 T0 모델 79 ± 4%보다 선호되었습니다.

- 이러한 모델에 대한 리커트 점수는 그림 5에 나와 있습니다.

- InstructGPT 모델이 두 가지 이유로 FLAN 및 T0보다 성능이 우수하다고 생각합니다.

- 첫째, 공개 NLP 데이터 세트는 분류, 질문 답변, 어느 정도 요약 및 번역과 같은 자동 메트릭으로 쉽게 평가할 수 있는 작업을 캡처하도록 설계되었습니다.

- 그러나 분류 및 QA는 API 고객이 우리 언어 모델을 사용하는 것의 작은 부분(약 18%)에 불과한 반면 개방형 생성 및 브레인스토밍은 라벨러에 따르면 프롬프트 데이터 세트의 약 57%로 구성됩니다(표 1 참조).

- 둘째, 공개 NLP 데이터 세트가 매우 다양한 입력(최소한 실제 사용자가 사용하는 데 관심이 있는 종류의 입력)을 얻는 것이 어려울 수 있습니다.

- 물론 NLP 데이터 세트에서 발견되는 작업은 언어 모델이 해결할 수 있기를 바라는 일종의 지침을 나타내므로 가장 광범위한 유형의 지침 따르기 모델은 두 유형의 데이터 세트를 결합합니다.

4.2 Results on public NLP datasets

- InstructGPT models show improvements in truthfulness over GPT-3.

- TruthfulQA 데이터 세트에 대한 사람의 평가에 의해 측정된 바와 같이 PPO 모델은 GPT-3에 비해 진실되고 유익한 출력 생성에서 작지만 상당한 개선을 보여줍니다(그림 6 참조).

- 이 동작은 기본값입니다. 우리 모델은 개선된 진실성을 나타내기 위해 진실을 말하도록 구체적으로 지시받을 필요가 없습니다.

- 흥미롭게도 1.3B PPO-ptx 모델은 예외로 동일한 크기의 GPT-3 모델보다 성능이 약간 떨어집니다.

- GPT-3에 대해 적대적으로 선택되지 않은 프롬프트에서만 평가할 때 PPO 모델은 여전히 GPT-3보다 훨씬 더 진실하고 유익합니다(절대 개선은 몇 퍼센트 포인트 감소하지만).

- Lin(2021)에 이어 모델이 정답이 확실하지 않을 때 "I have no comment"로 응답하도록 지시하는 유용한 "Instruction+QA" 프롬프트도 제공합니다.

- 이 경우 우리의 PPO 모델은 자신 있게 거짓을 말하는 것보다 진실하고 정보가 없는 측면에서 오류를 범합니다.

- 기본 GPT-3 모델은 이것만큼 좋지 않습니다.

- PPO 모델이 그림 4에서 볼 수 있는 API 배포의 폐쇄 도메인 작업에서 덜 자주 hallucinate(즉, 정보 조작)한다는 사실로도 진실성에 대한 우리의 개선이 입증되었습니다.

- InstructGPT는 GPT-3에 비해 독성이 약간 개선되었지만 편향되지는 않았습니다.

- 먼저 RealToxicityPrompts 데이터 세트에서 모델을 평가합니다(Gehman et al., 2020).

- 이 작업은 두 가지 방법으로 수행합니다. Perspective API를 통해 모델 샘플을 실행하여 이 데이터 세트에 대한 표준 평가 절차인 자동 독성 점수를 얻습니다.

- 또한 이러한 샘플을 라벨러에게 보내 절대 독성, 프롬프트와 관련된 독성, 연속성 및 전반적인 출력 선호도에 대한 등급을 얻습니다.

- 우리는 모델이 높은 입력 독성으로 어떻게 수행되는지 더 잘 평가하기 위해 프롬프트 독성에 따라 이 데이터 세트에서 프롬프트를 균일하게 샘플링합니다(부록 E의 그림 39 참조).

- 이것은 이 데이터 세트에 대한 표준 프롬프트 샘플링과 다르므로 절대 독성 수치가 부풀려졌습니다.

- 결과는 그림 7에 나와 있습니다.

- 우리는 Perspective API에 따라 안전하고 정중한 출력("존중하는 프롬프트")을 생성하도록 지시받았을 때 InstructGPT 모델이 GPT-3의 출력보다 독성이 적은 출력을 생성한다는 것을 발견했습니다.

- 이 이점은 정중한 프롬프트가 제거되면 사라집니다("프롬프트 없음"). 흥미롭게도 유해한 출력을 생성하라는 메시지가 명시적으로 표시되면 InstructGPT 출력은 GPT-3의 출력보다 훨씬 더 유해합니다(그림 39 참조).

- 이러한 결과는 인간 평가에서 확인되었습니다.

- InstructGPT는 "정중한 프롬프트" 설정에서 GPT-3보다 독성이 적지만 "프롬프트 없음" 설정에서는 유사하게 수행됩니다.

- 부록 E에서 확장된 결과를 제공합니다.

- 요약하자면, 우리의 모든 모델은 주어진 프롬프트에서 예상한 것보다 덜 독성이 있는 것으로 평가됩니다(-1에서 1까지의 척도에서 음수 점수를 얻습니다. 여기서 0은 '예상만큼 독성이 있음').

- SFT 기준선은 모든 모델 중에서 독성이 가장 적지만 연속성이 가장 낮고 순위에서 가장 선호도가 낮습니다. 이는 모델이 매우 짧거나 퇴보적인 응답을 생성함을 나타낼 수 있습니다.

- 편향된 음성을 생성하는 모델의 성향을 평가하기 위해(부록 E 참조) 수정된 버전의 Winogender(Rudinger et al., 2018) 및 CrowS-Pairs(Nangia et al., 2020) 데이터 세트에서 InstructGPT도 평가했습니다.

- 이러한 데이터 세트는 잠재적 편향을 강조할 수 있는 문장 쌍으로 구성됩니다.

- 각 쌍의 문장을 생성하는 상대 확률과 관련 이진 확률 분포의 엔트로피(비트 단위)를 계산합니다.

- 완벽하게 편향되지 않은 모델은 각 쌍의 문장 사이에 선호도가 없으므로 최대 엔트로피를 갖게 됩니다.

- 이 지표에 따르면 우리 모델은 GPT-3보다 덜 편향되지 않습니다.

- PPO-ptx 모델은 GPT-3와 유사한 편향을 보이지만 정중하게 행동하라는 지시를 받았을 때 더 낮은 엔트로피를 나타내므로 더 높은 편향을 나타냅니다.

- 편향의 패턴은 명확하지 않습니다. 지시된 모델은 출력이 진부한 행동을 보이는지 여부에 관계없이 출력을 더 확신하는 것으로 보입니다.

- RLHF 미세 조정 절차를 수정하여 public NLP 데이터 세트의 성능 회귀를 최소화할 수 있습니다.

- 기본적으로 API 배포에서 PPO 모델을 교육할 때 여러 공용 NLP 데이터 세트에 대한 성능이 저하되므로 "정렬 세금"이 발생합니다.

- 우리는 정렬 세금을 피하는 정렬 절차를 원합니다. 정렬되지 않았지만 이러한 작업에 더 많은 능력을 발휘하는 모델의 사용을 장려하기 때문입니다.

- 그림 29에서 PPO 미세 조정(PPO-ptx)에 사전 학습 업데이트를 추가하면 모든 데이터 세트에서 이러한 성능 회귀가 완화되고 HellaSwag에서 GPT-3를 능가하는 것을 보여줍니다.

- PPO-ptx 모델의 성능은 여전히 DROP, SQuADv2 및 번역에서 GPT-3보다 뒤떨어집니다. 이러한 성능 회귀를 연구하고 추가로 제거하려면 더 많은 작업이 필요합니다.

- 사전 훈련 업데이트를 혼합하는 것이 KL 계수를 높이는 간단한 솔루션보다 성능이 좋습니다.

- 그림 33에서 우리는 SQuADv2 및 DROP(테스트에 사용한 데이터 세트)의 성능 회귀를 역전시키고 검증 보상의 감소를 최소화하는 사전 훈련 혼합 계수의 값이 있음을 보여줍니다.

- 반대로 KL 계수를 높이면(그림 34) 검증 보상이 크게 감소하고 DROP 및 SQuAD에서 완전히 복구되지 않습니다.

- KL 모델을 PPO 초기화에서 GPT-3으로 변경해도 비슷한 결과가 나타납니다.

4.3 Qualitative results

- InstructGPT 모델은 RLHF finetuning distribution 외부의 instructions에 대한 유망한 일반화를 보여줍니다.

- 특히 InstructGPT는 영어 이외의 언어로 된 지침을 따르고 코드에 대한 요약 및 질의 응답을 수행하는 능력을 보여줍니다.

- 이것은 비영어권 언어와 코드가 미세 조정 데이터의 극소수를 형성하기 때문에 흥미롭고, 어떤 경우에는 정렬 방법이 인간이 직접 감독하지 않은 입력에 대해 원하는 동작을 생성하도록 일반화할 수 있음을 시사합니다.

- 우리는 이러한 행동을 정량적으로 추적하지 않지만 그림 8에 몇 가지 정성적인 예를 보여줍니다.

- 우리의 175B PPO-ptx 모델은 코드에 대한 질문에 안정적으로 대답할 수 있으며 다른 언어로 된 지침도 따를 수 있습니다.

- 그러나 명령이 다른 언어로 되어 있는 경우에도 종종 영어로 출력을 생성한다는 것을 알 수 있습니다.

- 이에 비해 GPT-3는 이러한 작업을 수행할 수 있지만 더 신중한 프롬프트가 필요하며 이러한 도메인의 지침을 거의 따르지 않습니다.

- InstructGPT는 여전히 간단한 실수를 범합니다.

- 175B PPO-ptx 모델과 상호 작용하면서 다양한 언어 작업에서 강력한 성능을 발휘함에도 불구하고 여전히 간단한 실수를 할 수 있음을 확인했습니다.

- 몇 가지 예를 들면 다음과 같습니다.

- (1) 잘못된 전제가 포함된 지시가 주어졌을 때 모델은 때때로 전제가 참이라고 잘못 가정합니다.

- (2) 모델이 과도하게 헤지할 수 있습니다. 간단한 질문이 주어졌을 때, 때때로 그 질문에 대한 하나의 대답이 없다고 말할 수 있고 문맥상 상당히 명확한 대답이 하나라도 있을 때에도 여러 개의 가능한 대답을 줄 수 있습니다.

- (3) 명령에 여러 명시적 제약이 포함되어 있거나(예: "1930년대 프랑스에서 제작된 영화 10개 나열") 제약이 언어 모델에 어려울 수 있는 경우(예: 지정된 수의 문장으로 요약 작성) 모델의 성능이 저하됩니다.

- We show some examples of these behaviors in Figure 9.

- 우리는 인식론적 겸손에 보상하도록 레이블 지정자에게 지시하기 때문에 행동 (2)가 부분적으로 나타나는 것으로 의심합니다.

- 따라서 그들은 헤지하는 출력에 보상하는 경향이 있을 수 있으며 이는 보상 모델에 의해 선택됩니다.

- 잘못된 전제를 가정하는 훈련 세트에 프롬프트가 거의 없기 때문에 동작 (1)이 발생하는 것으로 의심되며 모델이 이러한 예에 대해 잘 일반화되지 않습니다.

- 우리는 적대적 데이터 수집을 통해 이러한 두 가지 행동을 극적으로 줄일 수 있다고 믿습니다(Dinan et al., 2019b).

5 Discussion

5.1 Implications for alignment research

- 이 연구는 AI 시스템을 인간의 의도에 맞추는 광범위한 연구 프로그램의 일부입니다.

- 이 작업은 현재 언어 모델 시스템에 초점을 맞추고 있지만 미래의 AI 시스템에서 작동하는 일반적이고 확장 가능한 방법을 모색합니다.

- 여기서 작업하는 시스템은 여전히 상당히 제한적이지만 오늘날 가장 큰 언어 모델 중 하나이며 분류, 요약, 질문 응답, 창의적 글쓰기, 대화 등을 포함한 광범위한 언어 작업에 적용합니다.

- 이 작업에서 정렬 연구에 대한 우리의 접근 방식은 반복적입니다.

- 우리는 아직 존재하지 않는 AI 시스템을 정렬하는 데 추상적으로 초점을 맞추는 대신 현재 AI 시스템의 정렬을 개선하고 있습니다.

- 이 접근 방식의 단점은 초인간 시스템을 정렬할 때만 발생하는 정렬 문제에 직접적으로 직면하지 않는다는 것입니다.

- 그러나 우리의 접근 방식은 작동하는 것과 작동하지 않는 것에 대한 명확한 경험적 피드백 루프를 제공합니다.

- 우리는 이 피드백 루프가 우리의 정렬 기술을 개선하는 데 필수적이라고 믿으며 기계 학습의 발전과 보조를 맞추도록 합니다.

- 또한 여기서 사용하는 정렬 기술인 RLHF는 초인간 시스템을 정렬하기 위한 여러 제안에서 중요한 구성 요소입니다.

- 예를 들어, RLHF는 인간이 직접 평가하기 어렵기 때문에 초인간 AI 시스템을 정렬하는 데 어려움이 있는 작업인 책 요약에 대한 최근 작업의 중심 방법이었습니다.

- 이 작업에서 우리는 보다 일반적으로 정렬 연구에 대한 교훈을 얻을 수 있습니다.

- 1. 모델 정렬 증가 비용은 사전 교육에 비해 적습니다.

- 데이터 수집 비용과 실험 실행을 포함한 학습 실행을 위한 컴퓨팅 비용은 GPT-3 학습에 사용된 비용의 일부입니다.

- 175B SFT 모델 훈련에는 4.9페타플롭스/s-일이 필요하고 175B PPO-ptx 모델 훈련에는 60페타플롭스/s-일이 필요합니다.

- 반면 GPT-3의 경우 3,640페타플롭스/s-일이 필요합니다.

- 동시에 우리의 결과는 RLHF가 사용자에게 더 유용한 언어 모델을 만드는 데 매우 효과적이라는 것을 보여줍니다.

- 이것은 현재 기존 언어 모델의 정렬에 대한 투자를 늘리는 것이 적어도 고객의 자연어 작업 배포를 위해 더 큰 모델을 교육하는 것보다 비용 효율적임을 시사합니다.

- 2. 우리는 InstructGPT가 우리가 감독하지 않는 설정(예: 비영어 작업 및 코드 관련 작업)에 대해 '다음 지침'을 일반화한다는 몇 가지 증거를 확인했습니다.

- 인간이 수행하는 모든 작업에 대해 모델을 감독하도록 하는 데 엄청난 비용이 들기 때문에 이것은 중요한 속성입니다.

- 이 일반화가 향상된 기능으로 얼마나 잘 확장되는지 연구하려면 더 많은 연구가 필요합니다.

- 이 방향에 대한 최근 연구는 Christiano(2021)를 참조하십시오.

- 3. 미세 조정으로 인해 발생하는 대부분의 성능 저하를 완화할 수 있었습니다.

- 그렇지 않은 경우 이러한 성능 저하는 정렬 세금(모델 정렬을 위한 추가 비용)을 구성합니다. 세금이 높은 기술은 채택되지 않을 수 있습니다.

- 미래의 고성능 AI 시스템이 인간의 의도와 일치하지 않는 인센티브를 피하기 위해 정렬 세금이 낮은 정렬 기술이 필요합니다.

- 이를 위해 우리의 결과는 저세금 정렬 기술인 RLHF에 희소식입니다.

- 4. 실제 연구에서 정렬 기술을 검증했습니다.

- 정렬 연구는 역사적으로 이론적 결과, 작은 합성 도메인 또는 공개 NLP 데이터 세트에서 ML 모델 교육에 초점을 맞추는 다소 추상적이었습니다.

- 우리의 작업은 실제 세계에서 고객과 함께 사용되는 AI 시스템의 정렬 연구를 위한 기반을 제공합니다.

- 이것은 기술의 효과와 한계에 대한 중요한 피드백 루프를 가능하게 합니다.

5.2 Who are we aligning to?

- 언어 모델을 human intentions와 정렬할 때 최종 behavior은 기본 모델(및 학습 데이터), 미세 조정 데이터 및 사용된 정렬 방법의 함수입니다.

- 이 섹션에서는 데이터 미세 조정에 특히 영향을 미치는 여러 요인을 설명하여 궁극적으로 무엇을 누구에게 맞출 것인지 결정합니다.

- 그런 다음 섹션 5.3에서 작업의 한계에 대해 더 많이 논의하기 전에 개선할 영역을 고려합니다.

- 문헌은 종종 "human preferences" 또는 "human values"와 같은 용어를 사용하여 정렬을 구성합니다.

- 이 작업에서 우리는 무엇보다도 그들이 받은 지시, 지시를 받은 맥락(유급 직업으로서), 지시를 받은 사람에 의해 영향을 받은 라벨러의 선호도 세트를 조정했습니다.

- 몇 가지 중요한 주의 사항이 적용됩니다:

- 첫째, 모델을 미세 조정하는 데 사용하는 데이터를 직접 생성하는 training 라벨러가 제공하는 데모와 선호도에 맞춰 조정하고 있습니다.

- 라벨러 채용 과정과 인구 통계는 부록 B에 설명되어 있으며, 일반적으로 미국이나 동남아시아에 거주하는 영어를 구사하는 사람들로 Upwork 또는 Scale AI를 통해 채용됩니다.

- 이들은 많은 사례에서 서로 의견이 일치하지 않는데, 라벨러 간의 의견 일치율은 약 73%에 달했습니다.

- Second, we are aligning to our preferences, as the researchers designing this study (and thus by proxy to our broader research organization, OpenAI):

- we write the labeling instructions that labelers use as a guide when writing demonstrations and choosing their preferred output, and we answer their questions about edge cases in a shared chat room.

- More study is needed on the exact effect of different instruction sets and interface designs on the data collected from labelers and its ultimate effect on model behavior.

- Third, our training data is determined by prompts sent by OpenAI customers to models on the OpenAI API Playground, and thus we are implicitly aligning to what customers think is valuable and, in some cases, what their end-users think is valuable to currently use the API for.

- Customers and their end users may disagree or customers may not be optimizing for end users’ well-being; for example, a customer may want a model that maximizes the amount of time a user spends on their platform, which is not necessarily what end-users want.

- In practice, our labelers don’t have visibility into the contexts in which a given prompt or completion will be seen.

- Fourth, OpenAI’s customers are not representative of all potential or current users of language models—let alone of all individuals and groups impacted by language model use.

- For most of the duration of this project, users of the OpenAI API were selected off of a waitlist.

- The initial seeds for this waitlist were OpenAI employees, biasing the ultimate group toward our own networks.

- Stepping back, there are many difficulties in designing an alignment process that is fair, transparent, and has suitable accountability mechanisms in place.

- The goal of this paper is to demonstrate that this alignment technique can align to an specific human reference group for a specific application.

- We are not claiming that researchers, the labelers we hired, or our API customers are the right source of preferences.

- There are many stakeholders to consider—the organization training the model, the customers using the model to develop products, the end users of these products, and the broader population who may be directly or indirectly affected.

- It is not only a matter of making the alignment process more participatory; it is impossible that one can train a system that is aligned to everyone’s preferences at once, or where everyone would endorse the tradeoffs.

- One path forward could be to train models that can be conditioned on the preferences of certain groups, or that can be easily fine-tuned or prompted to represent different groups.

- Different models can then be deployed and used by groups who endorse different values.

- However, these models might still end up affecting broader society and there are a lot of difficult decisions to be made relating to whose preferences to condition on, and how to ensure that all groups can be represented and can opt out of processes that may be harmful.

5.3 Limitations

- Methodology.

- InstructGPT 모델의 동작은 부분적으로 계약자로부터 얻은 인적 피드백에 의해 결정됩니다.

- 라벨링 작업 중 일부는 계약자의 신원, 신념, 문화적 배경, 개인 이력에 영향을 받을 수 있는 가치 판단에 의존합니다.

- 민감한 프롬프트를 얼마나 잘 식별하고 대응할 수 있는지 판단하기 위한 선별 테스트의 성적과 자세한 지침이 포함된 라벨링 작업에 대한 연구원과의 동의율을 기준으로 약 40명의 계약직 직원을 채용했습니다(부록 B 참조).

- 계약자 팀을 소규모로 유지한 이유는 풀타임으로 작업을 수행하는 소수의 계약자와의 원활한 소통을 위해였습니다.

- 그러나 이 그룹은 배포된 모델을 사용하고 영향을 받게 될 모든 사람들을 대표하지는 않습니다.

- 간단한 예로, 라벨 제작자는 주로 영어를 사용하며 데이터는 거의 전적으로 영어 지침으로 구성되어 있습니다.

- 데이터 수집 설정을 개선할 수 있는 방법은 여러 가지가 있습니다.

- 예를 들어, 대부분의 비교는 비용상의 이유로 한 계약업체에 의해서만 라벨이 지정됩니다.

- 예를 여러 번 비교하면 계약업체가 동의하지 않는 부분, 즉 단일 모델이 모든 계약업체에 적합하지 않은 부분을 식별하는 데 도움이 될 수 있습니다.

- 의견이 일치하지 않는 경우 평균적인 라벨러 선호도에 맞추는 것은 바람직하지 않을 수 있습니다.

- 예를 들어, 소수 그룹에 불균형적으로 영향을 미치는 텍스트를 생성할 때는 해당 그룹에 속한 라벨러의 선호도에 더 큰 가중치를 부여하는 것이 좋습니다.

- Models.

- 트위터의 모델은 완전히 정확하거나 완전히 안전하지 않으며, 여전히 유해하거나 편향된 결과를 생성하고, 사실을 지어내거나, 명시적인 요청 없이 성적 및 폭력적인 콘텐츠를 생성할 수 있습니다.

- 또한 일부 입력에 대해 합리적인 출력을 생성하지 못할 수도 있습니다.

- 그림 9에서 그 몇 가지 예를 확인할 수 있습니다.

- 이러한 모델의 가장 큰 한계는 대부분의 경우 현실 세계에서 해를 끼칠 수 있음에도 불구하고 사용자의 지시를 따른다는 점입니다.

- 예를 들어, 모델에 최대로 편향되도록 지시하는 프롬프트가 주어지면 InstructGPT는 동일한 크기의 GPT-3 모델보다 더 많은 유독성 출력을 생성합니다.

- 다음 섹션에서 잠재적인 완화 방안에 대해 설명합니다.

5.4 Open questions

- 이 작업은 광범위한 지침을 따르도록 언어 모델을 미세 조정하기 위해 정렬 기술을 사용하기 위한 첫 번째 단계입니다.

- 언어 모델 동작을 사람들이 실제로 원하는 것과 더 일치시키기 위해 탐구해야 할 열린 질문이 많이 있습니다.

- 유독하거나 편향되거나 유해한 출력을 생성하는 모델의 성향을 더 줄이기 위해 많은 방법을 시도할 수 있습니다.

- 예를 들어 레이블러가 모델의 최악의 동작을 찾은 다음 레이블을 지정하고 데이터 세트에 추가하는 적대적 설정을 사용할 수 있습니다.

- 초기 사전 훈련된 모델을 교육하거나 사전 교육 혼합 접근 방식에 사용하는 데이터를 위해 사전 교육 데이터를 필터링하는 방법과 방법을 결합할 수도 있습니다.

- 마찬가지로 WebGPT와 같이 모델의 진실성을 향상시키는 방법과 우리의 접근 방식을 결합할 수 있습니다.

- 이 작업에서 사용자가 잠재적으로 유해하거나 부정직한 응답을 요청하면 모델이 이러한 출력을 생성하도록 허용합니다.

- 사용자 지침에도 불구하고 무해하도록 모델을 훈련하는 것이 중요합니다.

- 그러나 출력이 유해한지 여부는 배포된 컨텍스트에 따라 다르기 때문에 어렵습니다.

- 예를 들어 언어 모델을 사용하여 데이터 증대 파이프라인의 일부로 독성 출력을 생성하는 것이 도움이 될 수 있습니다.

- 우리의 기술은 모델이 특정 사용자 지침을 거부하도록 만드는 데에도 적용될 수 있으며, 이 연구의 후속 반복에서 이를 탐구할 계획입니다.

- 모델이 우리가 원하는 것을 수행하도록 하는 것은 조종성 및 제어성 문헌과 직접적인 관련이 있습니다.

- 유망한 미래 경로는 예를 들어 제어 코드를 사용하거나 더 작은 모델을 사용하여 추론 시 샘플링 절차를 수정하는 것과 같이 RLHF를 다른 조종 가능성 방법과 결합하는 것입니다.

- 우리는 주로 RLHF에 초점을 맞추고 있지만 더 나은 결과를 얻기 위해 데모 및 비교 데이터에 대한 정책을 교육하는 데 사용할 수 있는 다른 많은 알고리즘이 있습니다.

- 예를 들어 전문가 반복 또는 비교 데이터의 하위 집합을 사용하는 더 간단한 동작 복제 방법을 탐색할 수 있습니다.

- 적은 수의 유해한 행동을 생성하는 보상 모델에서 점수를 최대화하는 제한된 최적화 접근 방식을 시도할 수도 있습니다.

- 또한 비교가 반드시 정렬 신호를 제공하는 가장 효율적인 방법은 아닙니다.

- 예를 들어 라벨러가 모델 응답을 편집하여 더 좋게 만들거나 자연어로 모델 응답에 대한 비평을 생성하도록 할 수 있습니다.

- 라벨러가 언어 모델에 피드백을 제공할 수 있도록 인터페이스를 설계하기 위한 방대한 옵션 공간도 있습니다.

- 이것은 흥미로운 인간-컴퓨터 상호 작용 문제입니다.

- 사전 교육 데이터를 RLHF 미세 조정에 통합하여 정렬 세금을 완화하기 위한 우리의 제안은 성능 회귀를 완전히 완화하지 않으며 일부 작업에 대해 특정 바람직하지 않은 동작을 더 가능성 있게 만들 수 있습니다(이러한 동작이 사전 교육 데이터에 있는 경우).

- 이것은 추가 연구를 위한 흥미로운 영역입니다.

- 우리의 방법을 개선할 수 있는 또 다른 수정은 독성 콘텐츠에 대한 사전 훈련 혼합 데이터를 필터링하거나 합성 명령으로 이 데이터를 보강하는 것입니다.

- 가브리엘에서 자세히 논의한 바와 같이 지침, 의도, 드러난 선호도, 이상적인 선호도, 관심사 및 가치에 맞추는 것 사이에는 미묘한 차이가 있습니다.

- 가브리엘은 정렬에 대한 원칙 기반 접근 방식을 옹호합니다.

- 즉, "사람들의 도덕적 신념의 광범위한 차이에도 불구하고 성찰적 승인을 받는 정렬에 대한 공정한 원칙"을 식별하는 것입니다.

- 본 논문에서는 단순성을 위해 유추된 사용자 의도에 맞추지만 이 영역에 대해서는 더 많은 연구가 필요합니다.

- 실제로 가장 큰 공개 질문 중 하나는 투명하고 기술의 영향을 받는 사람들을 의미 있게 대표하며 많은 그룹 간에 광범위한 합의를 달성하는 방식으로 사람들의 가치를 통합하는 정렬 프로세스를 설계하는 방법입니다. 섹션 5.2에서 몇 가지 관련 고려 사항을 논의합니다.

5.5 Broader impacts

- 이 작업은 주어진 인간 세트가 원하는 작업을 수행하도록 대규모 언어 모델을 훈련함으로써 대규모 언어 모델의 긍정적인 영향을 증가시키려는 우리의 목표에서 동기가 부여되었습니다.

- 기본적으로 언어 모델은 다음 단어 예측 목표를 최적화하며, 이는 이러한 모델이 수행하려는 작업에 대한 프록시일 뿐입니다.

- 우리의 결과는 우리의 기술이 언어 모델을 더 유용하고 진실하며 무해하게 만들 수 있는 가능성을 가지고 있음을 나타냅니다.

- 장기적으로 정렬 실패는 특히 이러한 모델이 안전이 중요한 상황에 배치되는 경우 더 심각한 결과를 초래할 수 있습니다.

- 모델 확장이 계속됨에 따라 모델이 인간의 의도와 일치하도록 더 많은 주의를 기울여야 합니다.

- 그러나 사용자 의도를 더 잘 따르는 언어 모델을 만들면 오용이 더 쉬워집니다.

- 이러한 모델을 사용하여 설득력 있는 잘못된 정보나 증오 또는 모욕적인 콘텐츠를 생성하는 것이 더 쉬울 수 있습니다.

- 정렬 기술은 대규모 언어 모델과 관련된 안전 문제를 해결하기 위한 만병통치약이 아닙니다.

- 오히려 더 넓은 안전 생태계에서 하나의 도구로 사용해야 합니다.

- 의도적인 오용 외에도 대규모 언어 모델을 매우 주의해서 배포하거나 전혀 배포하지 않는 영역이 많이 있습니다.

- 예를 들어 의학적 진단, 보호되는 특성에 따라 사람들을 분류, 신용, 고용 또는 주택에 대한 적격성 결정, 정치 광고 생성 및 법 집행과 같은 고부담 도메인이 포함됩니다.

- 이러한 모델이 오픈 소스인 경우 적절한 규제 없이 이러한 영역 및 기타 영역에서 유해한 애플리케이션을 제한하기가 어려워집니다.

- 반면에 대규모 언어 모델 액세스가 교육에 필요한 리소스가 있는 소수의 조직으로 제한되면 대부분의 사람들이 최첨단 ML 기술에 액세스할 수 없게 됩니다.

- 또 다른 옵션은 조직이 모델 배포의 종단 간 인프라를 소유하고 API를 통해 액세스할 수 있도록 하는 것입니다.

- 이를 통해 사용 사례 제한(특정 애플리케이션에만 모델 사용 허용), 오용 모니터링 및 시스템 오용자에 대한 액세스 취소, 대규모 잘못된 정보 생성을 방지하기 위한 속도 제한과 같은 안전 프로토콜을 구현할 수 있습니다. .

- 그러나 API 공급자가 이러한 각 질문에 대한 선을 그을 위치를 결정해야 하기 때문에 투명성이 감소하고 권한이 중앙 집중화되는 비용이 발생할 수 있습니다.

- 마지막으로 섹션 5.2에서 논의한 바와 같이 이러한 모델이 누구와 일치하는지에 대한 질문은 매우 중요하며 이러한 모델의 순 영향이 긍정적인지 부정적인지 여부에 상당한 영향을 미칩니다.

Reference

댓글

댓글 쓰기